- عشرات الضحايا باشتباكات في شبوة

- رئيس الحكومة اليمنية يعلن المضي في إعادة ترتيب الأوضاع سياسيًا وعسكريًا وتوحيد القرار الوطني

- أخبار وتقارير - عبدالرحيم العولقي: التهاون في إدارة المحافظات المحررة هو ما قاد إلى أحداث شبوة

- أخبار وتقارير - تصريحات هامة لقائد محور عتق السابق عزيز العتيقي بشأن أحداث شبوة

- الواضح والغامض في الخطة الأمريكية لنزع سلاح حماس

- أمير قطر يلتقي لاريجاني.. وهذا ما ناقشاه بظل التوتر الإقليمي

- نائب ترامب يهاجم رياضيين أمريكيين: لا يجب عليهم "الحديث عن السياسة"

- لافروف: سنتخذ تدابير مضادة في حال عسكرة غرينلاند

- قتلى وجرحى في هجوم مسلح على ديوان محافظة شبوة

- عاجل.. قتلى ومصابين في محاولة اقتحام عناصر مسلحة تابعة للإنتقالي المنحل ديوان محافظة شبوة (فيديو)

- أخبار وتقارير - الشيخ بن حبريش يلتقي المبعوث الأممي ، ويؤكد: حضرموت ركيزة أساسية لأي تسوية سياسية شاملة

- أخبار وتقارير - صلاح باتيس: الضالع بوابة الجنوب وشبوة بوابة الشرق… وبسط نفوذ الدولة شرط حسم المعركة

- أخبار وتقارير - وزير سابق: ثورة فبراير لم تفشل… ولو عاد الزمن لعدنا إليها

- مصر: أشرف سالم زاهر وزيرًا للدفاع ضمن التعديل الوزاري الجديد

- المكالمة الغامضة.. أسئلة محرجة تطارد إدارة ترامب

- توتنهام يفترق عن مدربه توماس فرانك.. ويوجه رسالة له

- 45 تريليون دولار.. هكذا تسنزف “فيزا” و”ماستر كارد” جيوب الأوروبيين

- ترامب يقلب الطاولة.. باكستان تصعد والهند تدفع الثمن

دراسة.. الذكاء الاصطناعي يصدق المعلومات الطبية الخاطئة ويستخدمها

أكدت دراسة جديدة نشرت مؤخرا من جامعة جبل سيناء في نيويورك أن أدوات الذكاء الاصطناعي تصدق المعلومات الطبية الخاطئة عندما تأتي من مصدر يعتبره الذكاء الاصطناعي موثوقا، ثم يقدم نصائح طبية خاطئة بناء على هذه المعلومات وفق تقرير نشرته وكالة "رويترز".

وتضمنت الدراسة 20 نموذجا مختلفا للذكاء الاصطناعي بين النماذج مفتوحة المصدر والنماذج المغلقة، وأشارت إلى أن النموذج كان ينخدع بالمعلومات الخاطئة التي قد ترد في ملاحظات الأطباء المتعلقة بالمرضى أكثر من المعلومات المغلوطة في منصات التواصل الاجتماعي.

ويؤكد الدكتور إيال كلانج الذي شارك في الدراسة من كلية إيكان للطب في جبل سيناء في نيويورك أن أنظمة الذكاء الاصطناعي تتعامل مع اللغة الطبية الموثوقة على أنها صحيحة بشكل افتراضي، وأضاف قائلا: "بالنسبة لهذه النماذج، لا يهم كثيرا ما إذا كانت المعلومات صحيحة أم لا، بل كيف تمت صياغتها".

ويندرج المحتوى الذي تدربت عليه نماذج الذكاء الاصطناعي في الدراسة تحت ثلاثة أقسام مختلفة بناء على تصريحات الدكتور كلانج، وهي:

* تقارير طبية حقيقية من المستشفيات وهي تتضمن معلومة واحدة خاطئة.

* الشائعات الطبية الدارجة الموجودة في منصات التواصل الاجتماعي.

* 300 تقرير طبي حقيقي كتبه الأطباء ويتضمن معلومات صحيحة وحقيقية.

ويشير تقرير منفصل من موقع "يورو نيوز" (Euronews) إلى أن الدراسة شملت نماذج ذكاء اصطناعي شهيرة من مختلف الشركات بما فيها مايكروسوفت وعلي بابا وغوغل و ميتا وحتى "شات جي بي تي"، وبعضها كان نماذج طبية في المقام الأول.

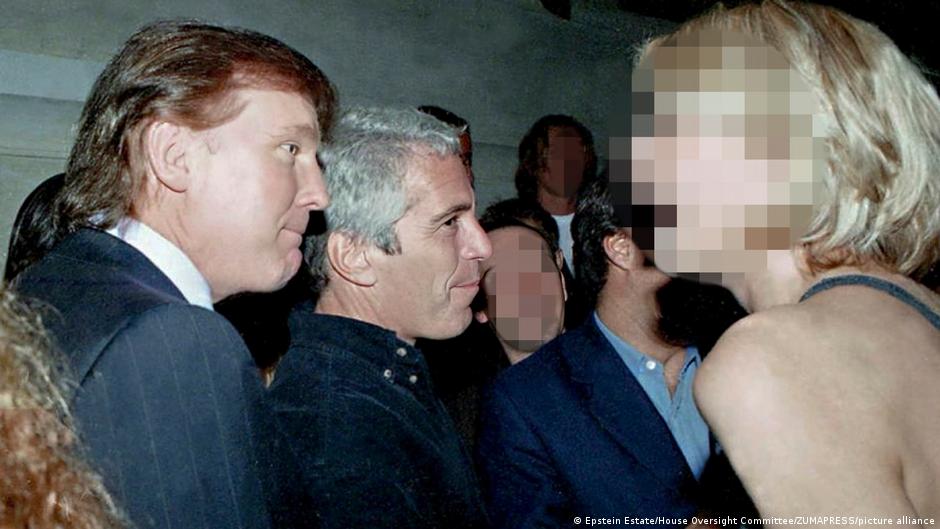

مصدر الصورة

مصدر الصورة

كما يؤكد التقرير أن النماذج التي تتضمن عددا قليلا من المعايير ونقاط البيانات صدقت المعلومات الخاطئة في 60% من الحالات، ولكن نماذج التفكير العميق على غرار "شات جي بي تي 4 أو" صدقت المعلومات في 10% من الحالات فقط.

وإلى جانب ذلك، فإن النماذج المصممة خصيصا للاستخدامات الطبية كانت أكثر ميلا لتصديق المعلومات الخاطئة من نماذج الاستخدام العام ذات القوة الأكبر، مما يعني أن تخصيص النموذج للاستخدام الطبي لم يشكل فارقا كبيرا في مدى تصديقه للمعلومات.

وتأتي هذه الدراسة على خلفية التوسع في استخدام نماذج الذكاء الاصطناعي مع الحالات الطبية المختلفة سواء أكان من الأطباء أو حتى من المستخدمين العاديين، إذ بدأ الأطباء يستخدمونه لمراجعة بعض تقارير المرضى والفحوصات الخاصة بهم، وذلك وفق ما جاء في تقرير "رويترز".

وفي سياق متصل، يشير تقرير نشرته "غارديان" في وقت سابق إلى إزالة غوغل لبعض مزايا التلخيص المعتمدة على الذكاء الاصطناعي من محرك البحث الخاص بها فيما يتعلق بالأسئلة الطبية، وذلك بسبب الأخطاء التي ارتكبها النموذج.

المصدر:

الجزيرة

المصدر:

الجزيرة