- قمة مبادرة "بالعربي" في الدوحة تجمع المبدعين لتجديد الفكر بلغة الضاد

- الحرب على غزة.. خسائر للاحتلال ومعارك ضارية وحصيلة ثقيلة من الشهداء

- من التدبير إلى التغيير.. المغرب يكثف التحركات الدبلوماسية في ملف الصحراء

- دعم مالي كبير من الخليج لمصر ومحادثات تجارة حرة بين أوروبا والإمارات

- روسيا تستعيد البلدة ما قبل الأخيرة الخاضعة لسيطرة أوكرانيا بكورسك

- إيران وأميركا.. انتهاء الجولة الثانية من محادثات النووي

- مباشر.. مباراة الأهلي ضد صن داونز (0-0) في دوري أبطال أفريقيا

- حقيقة عمل ممثلة في حقول الفراولة

- الشبكة السورية تطرح خريطة طريق مفصلة للعدالة الانتقالية في سوريا

- مقتل جندي إسرائلي وإصابة 4 باستهداف مركبة مدرعة شرقي غزة

- المجر وإسرائيل.. حلف المارقين وقصة السجادة الحمراء لمتهم بالإبادة

- ما الذي يخشاه الإيرانيون من نقل المباحثات النووية إلى روما؟

- رسائل شديدة اللهجة.. مشروع عقاري للمسلمين في تكساس يثير زوبعة

- حماس تعلن مقتل العنصر المكلف بحماية الرهينة "المفقود"

- السيسي: مصر تدعم الأردن في مواجهة كافة أشكال الإرهاب

- معاريف: انقسام بمحيط نتنياهو بعد تأجيل ترامب الخيار العسكري ضد إيران

- راشد الغنوشي من داخل سجنه: التهم ضدنا سياسية وملفقة

- سلوت يعلّق على إمكانية تتويج ليفربول بلقب الدوري هذا الأسبوع

أي أخلاق للذكاء الاصطناعي؟ حوار مع العالم السوري إياد رهوان

مصدر الصورة

مصدر الصورة

إياد رهوان عالم سوري صعد نجمه عالمياً خلال السنوات الماضية، بعد أن أشرف على دراسات أحدثت وقعاً كبيراً وانتشرت انتشاراً واسعاً.

محور اهتمام رهوان هو سلوك الآلة في عصر الذكاء الاصطناعي، وآثار انتشارها في المجتمعات البشرية كفاعل اجتماعي جديد.

أمضى الجزء الأكبر من طفولته في الإمارات التي يعتبرها بمثابة بلده الثاني، وقد أخذته رحلته مع العلم إلى أستراليا والولايات المتحدة، قبل أن يستقر في ألمانيا حيث أسس مركز الإنسان والآلة في معهد "ماكس بلانك" Max Planck للتنمية البشرية.

حاورت البروفيسور إياد عبر الإنترنت، فتحدث عن سر الطفرة الأخيرة في الذكاء الاصطناعي، وكيف وجدنا أنفسنا أمام آلات تسلك سلوكاً "مبهماً" وتنتج ظواهر "لم نخطط لها حين هندسنا هذه النظم". كما سألته عن أكثر ما يخيفه من احتمالات تطوّر الذكاء الاصطناعي.

مصدر الصورة

مصدر الصورة

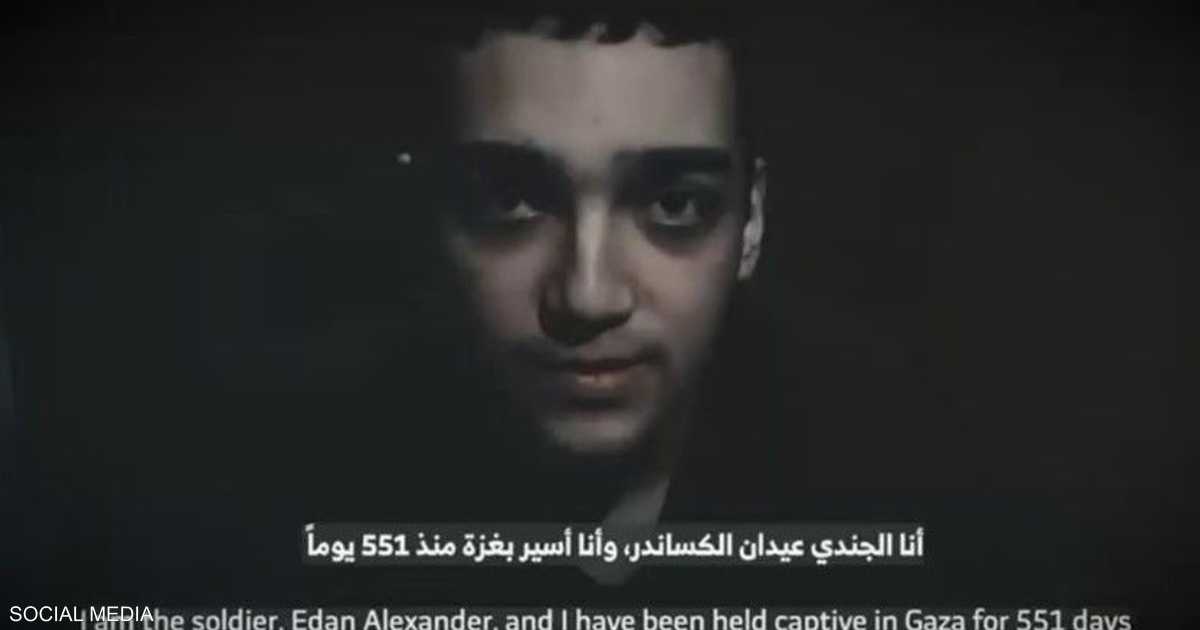

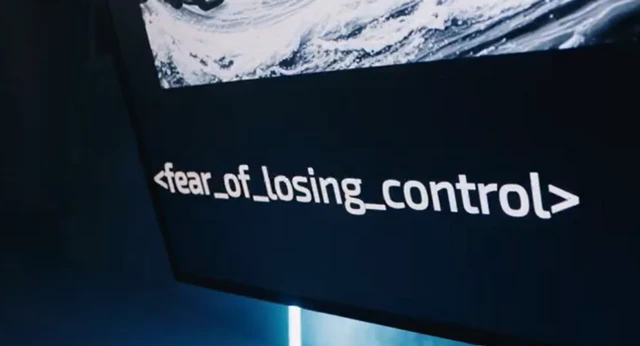

الآلة خائفة من الصورة.

هذا ما يتبدى لنا من ردة فعل "اوبتيلينس ثوتس" OptiLens Thoughts، البرنامج المزود بالذكاء الاصطناعي، على صورة رقائق الكترونية متشظية، تبدو كأنها أجزاء من آلة تفجرت وتبعثرت في كل حدب وصوب.

"هذا العمل الفني الرقمي يصيبني بالاضطراب"، تقول الآلة وتضيف: "كأن بياناتي أنا تتشظى وتنكشف".

التفاعل هذا هو جزء من مشروع يحمل عنوان "روعوا الآلة"، Spook the Machine، وهو يتيح للمشترك أن يستكشف "مخاوف" آلة معينة مزودة بالذكاء الاصطناعي، فيكتب أمراً لتوليد صورة "مخيفة" وتقوم الآلة بتقييمها وتقدم رد فعلها، الذي قد يتراوح بين "اللامبالاة الكاملة والرعب الشديد".

المشروع وليد مخيلة إياد رهوان، وهو عالم سوري ومؤسس ورئيس مركز الإنسان والآلة في معهد ماكس بلانك الألماني.

صحيح أن الموضوع لا يخلو من بعض اللهو، فهو ليس – حتى اللحظة - مبنياً على قناعة بأن الآلة فعلاً تشعر كما نشعر.

لكنه أيضاً جديّ للغاية، إذ يهدف إلى الغوص عميقاً في جانب من جوانب الذكاء الاصطناعي؛ قدرته على محاكاة العاطفة البشرية، مع ما تحمله من فرص ومخاطر. وهو يهدف أيضاً الى إشراك عموم الناس في التفكير والتأمل بكل هذا، وإلى جمع البيانات للاستفادة منها في بحث التفاعلات بين البشر والآلة.

"الآلة الأخلاقية"

مصدر الصورة

مصدر الصورة

هذه ليست المرة الأولى التي يتوجه فيها رهوان إلى الناس في مشروع تفاعلي من هذا النوع.

فقبل سنوات أطلق مشروع "الآلة الأخلاقية" The Moral Machine، طرح من خلاله معضلات أخلاقية قد تواجه آلات الذكاء الاصطناعي التي تجد نفسها أمام خيارات "تعنى بحياة الانسان وسلامته."

تحت خانة "احكم"، أنتم مدعوون لتحكموا على الخيارات المحتملة أمام سيارة ذاتية القيادة. لنفترض مثلاً أن مكابح السيارة قد تعطلت، وعلى الآلة التي تقودها أن تختار بين الارتطام بحاجز إسمنتي وقتل خمسة ركاب، أو الانحراف وقتل خمسة مشاة يعبرون الطريق بشكل غير قانوني. هذا مجرد مثال وعليه تنويعات وتفصيلات كثيرة، تتيح لكم أنتم أن تقولوا ما هي خياراتكم الأخلاقية المفضلة في كل حالة. بذلك يشرك المشروع الناس في التفكير بهذه المعضلات، وكذلك يتم جمع البيانات حول النظرة الرائجة عن المعايير الأخلاقية التي ينبغي علينا أن نلقنها للآلة.

يقول رهوان: "أصبنا بالصدمة لمدى انتشار الموقع. أكثر من 10 ملايين إنسان قاموا بالمشاركة حتى الآن."

وجاءت المشاركات من مختلف انحاء العالم، إذ قُدمت التجربة بعشر لغات (بما فيها العربية) لقياس الفوارق الثقافية وانعكاسها على النظرة الأخلاقية. ويقول رهوان إن علماء الاجتماع أيضاً باتوا يستخدمون بيانات المشروع لفهم الاختلافات الثقافية بشكل عام، أي أنه خرج عن نطاق الذكاء الاصطناعي إلى نطاق علمي أوسع.

السيارات ذاتية القيادة مجرد مثال على المجالات الواسعة التي اقتحمتها الآلات في المجتمع لتصبح – كما يقول رهوان – فاعلاً اجتماعياً لا نزال في بداية محاولاتنا لفهمه.

"قوة تأثير هائلة"

ينكب رهوان ومختبره في برلين على رصد أثر الآلات وفعلها في المجتمع، ويقول إنه يقترب من نشر دراسة هي الأهم لمختبره منذ دراسات "الآلة الأخلاقية".

"نحن نعمل على بحث وهو قيد التحكيم الآن في مجلة علمية. وجدنا أن تشات جي بي تي بإمكانه تغيير الكلمات التي ننتقيها في الحوار".

البحث قائم على تحليل مئات الآلاف من حلقات البودكاست الحوارية التي أظهرت أن الناس أصبحوا يقلدون تشات جي بي تي ChatGPT بطريقة انتقائه الكلمات.

فهناك كلمات معينة يستخدمها تشات جي بي تي بمعدلات أكثر من معدلات استخدامها لدى الناس عامة، وقد رصد المختبر طفرة في استخدامها في الحوارات بين البشر بعد صعود تشات جي بي تي. ويقول رهوان: "يمكننا القول إن التفاعل مع تشات جي بي تي هو السبب".

المسألة حتى الآن تقتصر على كلمات ليست لها أهمية سياسية او اجتماعية، لكن رهوان يجزم أن أهمية البحث تكمن في اكتشاف دليل على الظاهرة، وأنها حتماً ستتكرر في أمور ذات أهمية وتأثير، وقد يكون لها "تداعيات جيوسياسية، ويمكن أن تشن حرباً إعلامية" بمثل هذه التكنولوجيا.

يقول رهوان "تشات جي بي تي أصبح له قوة تأثير ثقافي هائلة، فهو يتحدث مع 300 مليون إنسان شهرياً بشكل شخصي وحميمي إلى حد ما - "حوار شخصي مفصل لك. يمكنه أن يؤثر عليك؛ في سلوكك الصحي وفي سلوكك الاستهلاكي. لحساب من؟ حالياً، ليس هناك أي تقنين لهذا".

مصممو الآلة لا يفهمونها؟

رهوان يشعر بفجوة كبيرة بين سرعة انتشار الآلة كفاعل اجتماعي في الحيز العام من جهة، وقدرتنا على إحاطتها فهماً من جهة ثانية. حتى أنه يعتقد أن علماء الكومبيوتر والمبرمجين الذين يصممون آلات الذكاء الاصطناعي عاجزون عن فهمها وحدهم، ويحتاجون إلى خبراء وعلماء من مجالات أخرى.

انطلاقاً من هذا، اشترك مع عدد من العلماء في كتابة مقال في مجلة "نايتشر" Nature، يدعو فيه إلى تأسيس مبحث جديد، أسماه العلم السلوكي للآلة، يستفيد من اختصاصات متنوعة، ويدرس الآلة من الخارج.

إليكم جزءاً من الحوار مع البروفيسور إياد رهوان بعد اختصاره وتحريره للوضوح:

مصدر الصورة

مصدر الصورة

أولاً، هل يمكن أن تعطينا نبذةً صغيرةً عنك؟

أنا ولدت في حلب في سوريا وذهبت إلى الإمارات بعمر 4 سنوات. تخرجت في الإمارات ودرست علم الحاسوب في جامعة الإمارات.

ثم هاجرت إلى أستراليا، وحزت على درجة الدكتوراه هناك في علم الحاسوب، ثم عدت الى الإمارات ودرّست في جامعتين؛ البريطانية في دبي ومعهد "مصدر" للعلوم والتكنولوجيا المرتبط ب إم آي تي، MIT.

ثم وجدت نفسي بروفيسوراً في إم آي تي وكانت قفزة ممتازة، وقد قدم لي معهد مصدر في أبو ظبي الفرصة للذهاب والتعاون مع العلماء في إم آي تي، وهذا ما فتح لي الأبواب، والحمد للّه.

ثم استقدموني إلى هنا في برلين، حيث أسست مركز أبحاث هو مركز الإنسان والآلة في معهد ماكس بلانك للتنمية البشرية، وهو معهد موجود منذ السبعينات، وأنا أحد رؤسائه.

ماذا تقصد حين تقول إن الآلة أصبحت "فاعلة" في المجتمع؟

الفاعل هو الشيء الذي يتحرك من تلقاء ذاته. فالحاسوب أو "الكومبيوتر" كان جماداً، كالطاولة أو الكرسي. يمكنك أن تستخدمه استخدامات معينة، لكن لا تلقائية له في الحركة والفاعلية. الإنسان يبادر بالفعل، والكومبيوتر يوفر بيانات أو اتصالات. مع الذكاء الاصطناعي، بدأ هو الذي يحرك نفسه، وإن كان الإنسان في النهاية المحرك الأساسي في العلاقة.

الآن تكثر المجالات حيث للكومبيوتر تلقائية واستقلالية. إنه يشتري ويبيع أسهم، مثلاً.

هناك خوارزميات متروكة لنفسها، نحن ننام وهي تستمر في البيع والشراء. لديها فاعلية، استقلالية إلى حدٍ ما، حتى لو كانت وكيلاً لنا، إذ خولناها أن تتصرف بطريقة معينة وتؤدي غرضاً معيناً.

الذكاء الاصطناعي التوليدي نفسه كان في البداية ردة فعل فقط. أنا أتكلم معه وهو يستجيب. لكننا الآن ندخل في مرحلة يمكن تسميتها الذكاء الاصطناعي ذو الفاعلية - المتمثلة بما بات يعرف بـ "ايجتنتك إيه آي Agentic AI". أنا أوكل إليه أعمالاً معينة، وهو يدفع نفسه لتحقيقها بشكل مستقل. ومع الوقت ستكون له استقلالية أكثر وأكثر.

دعوتم منذ ستة أعوام لتأسيس مبحث جديد، العلم السلوكي للآلة. هل تم ذلك؟

لا أحد يخترع من الصفر، الجميع يبني على ما سبق. فكرة العلم السلوكي للآلة كانت موجودة. هيربيرت سايمون مثلاً كتب كتاباً اسمه علوم الأشياء المصطنعة، Sciences of the Artificial، عام 1969.

طرح سايمون فكرة دراسة ليس فقط الطبيعة والظواهر الطبيعية كالشجر والجو والمياه والقوى والظواهر الفيزيائية، بل أيضاً الأشياء التي صنعناها نحن؛ أن ندرس الجسور والمباني بشكل علمي، كأننا نراها للمرة الأولى. كأنها جزء من الطبيعة.

تبلورت الفكرة إلى أن أصبحت هناك حاجة إلى أن تكون مجالاً له أسس علمية، وليس فقط فكرة يتحدث عنها البعض.

علينا أن نتفق ما هي الأسئلة الأساسية التي يجب أن نجيب عنها في هذا المجال، لهذا دعوت مجموعة من العلماء من مختلف المجالات؛ الاقتصاد والعلوم سياسية وعلم النفس وعلم الاعصاب، وعلم الكومبيوتر طبعاً، وعلم الإنسان.

قلت: "يا جماعة العلم هذا ليس فقط فرع من فروع علم الكومبيوتر، بل يجب أن يكون علماً أكبر من علم الكومبيوتر، وأن يشمل كل العلوم السلوكية لتساعدنا على فهم سلوك الآلة وتعامل الآلة مع الإنسان".

بماذا يهتم العلم السلوكي للآلة تحديداً؟

عند محاولة فهم سلوك الآلة، يمكننا التعامل معها كما نتعامل مع كائن حي (كالفأر مثلاً)؛ ندرس تصرفاتها ونلاحظ ردود أفعالها في بيئة معينة.

حين تضع فأراً في متاهة، أنت تدرسه بشكل منعزل. لكن بمجرد أن تضعه في بيئة طبيعية، سيتفاعل مع حيوانات أخرى، مع فريسته ومفترسه، فيصبح الموضوع أكثر تعقيداً.

الشيء نفسه بالنسبة للآلة: يمكن لنا أن ندرس سلوك الآلة بشكل منعزل، ونحن نفعل ذلك، في مختبري وفي أماكن أخرى. مثلاً، نحاول أن نفهم تشات جي بي تي: ما هي شخصيته، وكيف يتكلم، وما هي أفكاره السياسية. لو وضعته في موقع التفاوض، هل يفاوض بأريحية أم لا، وهل هو صارم أم مرن؟

يمكننا دراسة ذلك على الكومبيوتر من خلال المحاكاة، لكن في النهاية ستتفاعل الآلة مع البشر - مع أطفال، مع أطباء، وستقدّم نصائح أو اقتراحات - لذلك، لا يمكن فصل دراستها عن الإنسان، بل يجب فهم سلوكها ضمن سياق تفاعلها مع السلوك البشري.

أصبحت الآلة الآن جزءاً من المجتمع، ويجب أن نفهم سلوكها، وسلوكها يعتمد على سلوك الإنسان وتفاعله معها. وبالتالي، نحتاج إلى نظرة شمولية لهذا السلوك.

كيف يمكن لمن صمم آلة ما أن يعجز عن فهم سلوكها؟

مصدر الصورة

مصدر الصورة

نحن نفكر بالآلة كما نفكر بالتكنولوجيا القديمة، كالغسالة مثلاً، أي كنظام له مهمة محددة ودور محدد، وهو دور واضح.

هناك طريقة للتفاعل مع الغسالة؛ تضغط زراً ثم تحدث الأمور. والمهندس الذي صمم الآلة يفهمها تماماً وعليه فقط أن يوصل هذا الفهم للمستخدم الذي لا يفهمها.

لكننا الان أمام آلة تتعلم تلقائياً، تتعلم من البيانات بشكل مباشر. الطفرة التكنولوجية التي حصلت في الذكاء الاصطناعي نتجت عن هذا المفهوم.

فبدلاً من الطريقة التي اعتُمدت لعقود، حيث يقوم المبرمج بإعطاء الآلة كل المفاهيم والقواعد السلوكية، تَوصّل العلماء إلى أن الأفضل هو تزويد الآلة ببيانات عن العالم، وتركها تتعلم بنفسها.

قدرة الآلة على التعلُّم الذاتي تُمكّنها من معرفة أمور لم نخبرها إياها. وقد تتصرف بطرق تفاجئنا وتصبح سلوكياتها غير قابلة للتنبؤ بالكامل.

ما هي خلاصة اكتشافاتكم من مشروع "الآلة الأخلاقية"؟

الاكتشاف الأساسي هو الاختلافات الثقافية حول ما نتوقع من الآلة، وما هي الأخلاق التي نتمنى أن نراها في الآلة. الآراء تختلف من ثقافة إلى ثقافة، وبالتالي بناء الذكاء الاصطناعي يجب أن يأخذ الاختلافات الثقافية بعين الاعتبار. لا يمكن بناء سيارة تحترم قانون أو عرف بلد معين ثم تصديرها إلى بلد ثاني حيث يمكن أن تصطدم مع الأعراف المحلية.

أعتقد أننا أول من وجد هذه الفروقات بشكل واضح وكبير من خلال الآلة الأخلاقية، وهناك اختلاف على مستوى العالم بالكامل لأننا حللنا تقريباً كل الدول في العالم.

وفي بعض الحالات الرأي العام قد لا يكون الأكثر صواباً. أحياناً، على سبيل المثال، يقول الرأي العام إن على السيارة ذاتية القيادة أن تفضل إنقاذ رجل الأعمال على إنقاذ رجل مشرد. نحن نرى أن هذا ضد كرامة الإنسان. نحتاج أن تُسنّ قوانين تأخذ كل هذا بعين الاعتبار: متى نأخذ الاختلافات الثقافية بعين الاعتبار، متى نأخذ الرأي العام بعين الاعتبار ومتى نتجاهل الرأي العام. نحن نضع كل ذلك موضع نقاش.

وبالنسبة إلي، السيارات ذاتية القيادة ليست أهم مجال تظهر فيه الخلافات الثقافية. قد تكون الاختلافات أكبر في مجال ألعاب الأطفال.

الذكاء الاصطناعي وألعاب الأطفال

الذكاء الاصطناعي حتماً سينتشر في الألعاب. الدمى كـ"الباربي" Barbie، وما يشبهها، كلها سوف تتحدث إلى الأطفال قريباً. ما هي المعايير السلوكية المتماشية مع المعايير الثقافية لتعامل هذا الذكاء الاصطناعي مع أطفالي بشكل يناسبني ويناسب ثقافتي؟ من الذي يقرر أنها آمنة، مثلاً، وأنها لن تشجع الطفل على التهور؟

كل هذه المعايير غير موجودة حالياً، ليس لدينا منظومة علمية متكاملة قادرة على إعطائنا كل هذه المعايير.

ما العوائق القانونية التي تواجه من يريد دراسة وفهم الذكاء الاصطناعي والخوارزميات؟

العائق القانوني يتكون من شقّين: الملكية الفكرية التي تمنعني من الحصول على الخوارزمية لأنها محمية ومخبأة في الشركة، حتى أن الموظف لا يمكنه أن يأخذها معه إذا ترك الشركة. والآخر هو أنه ليس بإمكاني حتى أن أخترق أو "أهكّر" الموقع، لفهم سلوك الآلة، لأنهم سيرفعون علي قضية.

أنا لدي طالب سابق عمل لمدة سنتين على بحث مع إحدى شركات التواصل الاجتماعي، لكن الشركة في النهاية قالت له ممنوع نشر البحث لأن النتائج تضر بنا مالياً. كل العمل ذهب إلى القمامة، والرجل ترك العلم بالكامل ولجأ إلى مجال آخر، مختلف كلياً.

ثم، إذا أردتُ ان أدرس كيف تعمل خوارزميات تحديد الأسعار، علي أن أقوم بمحاكاة زبائن مختلفين. لكن بما أني لست زبوناً حقيقياً يمكن لهذه الشركة أن تقول إن هذا بمثابة "هاكينغ" اختراق غير قانوني. وفعلياً تم رفع قضايا ضد علماء كانوا يريدون فهم مثل هذه الخوارزميات، وكيف تعمل، تحت قوانين الهاكينغ والأمن السيبراني.

المنظور السلوكي لفهم الآلة يحل بعض هذه المشاكل، إذ يمكنني أن افهم الكثير عن خواص وسلوكيات الخوارزمية دون أن يكون لدي وصول للبرنامج نفسه.

أما قانونياً، فالحل أن نفرق بين من يحاول فهم سلوك الآلة لأغراض علمية، ومن يقوم بهذه الأمور ليتحايل عليها أو يسرق أو ينشر بيانات كاذبة أو معلومات خاطئة. يجب أن يميز القانون، وألا يتم تجريم العمل العلمي في هذا المجال، على الأقل.

ويمكننا أن نذهب أبعد من ذلك: يمكننا أن نفرض على شركات أن تسهل العمل العلمي لدراسة الخوارزميات التي تشغلها، كي لا يكون للشركة حق الفيتو على ما يمكن نشره. وإلا سيبقى الكثير من الأسئلة التي تخص الصالح العام لا يمكننا أن نجيب عنها علمياً، بسبب أن القانون يمنعنا أو لا يعطينا الحق بذلك.

ما هي أكثر السيناريوهات التي تخيفك في تطور الذكاء الاصطناعي؟

هناك العديد من سيناريوهات الخيال العلمي التي تتحدث عن فقدان السيطرة على الآلة، كما في أفلام مثل تيرمينايتور. لكني أشعر أنها لا تزال خيالية وبعيدة عن الواقع في الوقت الحالي.

أما ما يخيفني أكثر فهو أن يكون الذكاء الاصطناعي منحصراً في أيدي أشخاص معينين دون غيرهم، وأن يؤدي ذلك إلى خلل كبير في توازن القوى في العالم. هذا يخيفني أكثر. بمعنى أن يكون لدول تفوق كبير في الذكاء الاصطناعي، على حساب دول أخرى، ما سيحدث عدم توازن - اقتصادياً وعسكرياً وثقافياً - بتداعيات مخيفة. أتمنى أن يكون الذكاء الاصطناعي متوفراً للجميع، كي نتنافس بشكل إيجابي بكل المجالات وأن تكون لنا نفس الأدوات.

هل تعتقد أن الدول والمجتمعات العربية ستلحق بركب موجة الذكاء الاصطناعي؟

أكيد، سوف نلحق الموجة. لدينا إمكانيات بشرية. لدينا علماء أقوياء داخل وخارج العالم العربي. فنحن لا نقلّ عن أي شعب آخر من حيث الإمكانيات البشرية. وهناك استثمار قوي في عدة دول عربية في مجال الذكاء الاصطناعي. كما أن هناك مسألة مهمة، وهي أن الطفرات التي تحصل في الذكاء الاصطناعي سريعة جداً وهناك انفتاح في توفير نماذج الذكاء الاصطناعي.

نموذج ذكاء اصطناعي قد يكون كلف 500 مليون دولار لتدريبه، يمكن لأي شخص تحميله والحصول عليله جاهزاً واستخدامه. هذا يعني أنه بإمكاننا أن نُحدِث طفرة في هذا المجال. وعدم وجود الاستقلالية التامة في هذا المجال ليست مشكلة، فحتى الدول المتقدمة ليست مستقلةً بشكل كامل.

المهم أن نقدم ولا نخاف. لدينا الإمكانية ونحتاج فقط الشجاعة. وهي موجودة إن شاء الله.

المصدر:

بي بي سي

المصدر:

بي بي سي