- نائب رئيس مجلس الشورى يطلع على نشاط وزارة النقل

- الانتقالي يتخوف من اتصالات صنعاء والرياض

- غزة بعد الاتفاق.. القسام تسلم جثة أسير وتحركات أميركية للمضي قدما بترتيبات المرحلة الثانية

- مصدر يوضح تفاصيل مساعي إدارة ترامب للدفع بقرار أممي بشأن "قوة غزة"

- سقط على أرض الملعب فجأة.. وفاة مدرب الخلود السعودي السابق

- تنظيم محاضرة توعوية حول جرائم الابتزاز الإلكتروني في كلية المجتمع بسيئون

- السفير فقيرة يبحث مع مسؤول أردني العلاقات الثنائية بين البلدين

- وكيل محافظة مأرب يتفقد أعمال الترميم والتجهيز في مستشفى الحزمة بمديرية

- الوزير الزعوري: الحرب الحوثية تسببت في وقوع أكثر من 80 بالمائة من السكان تحت خط الفقر

- نائب وزير التربية يضع حجر الاساس لبناء مدرسة اساسية بمأرب بتمويل ماليزي

- اليمن يشارك في ورشة العمل العربية حول المعايير الإنسانية لتأهيل المحكوم عليهن

- ندوة حقوقية بمأرب تدعو لتعزيز حماية الصحفيين وإطلاق سراح المختطفين

- كيف أثار مقطع مسرب من منشأة "سدي تيمان" فضيحة وطنية بإسرائيل؟

- مصادر تكشف لـCNN ما حدث قبل تهديد ترامب لنيجيريا بعمل عسكري

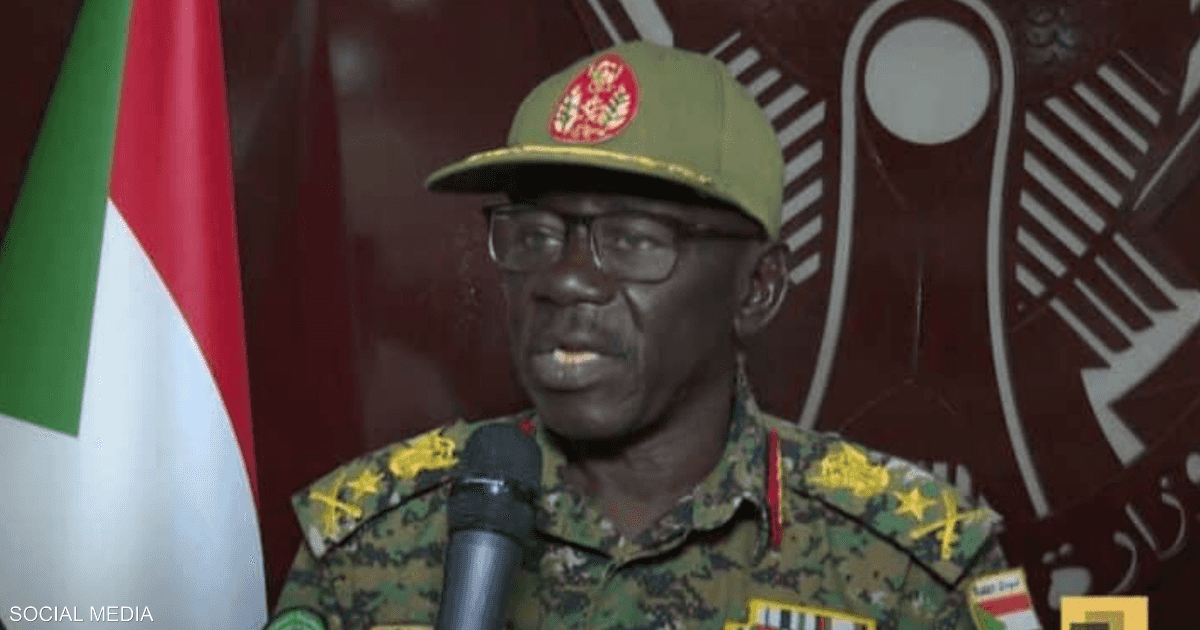

- مجلس الأمن والدفاع السوداني يدعو لـ"تعبئة شعبية عامة" لمواجهة الدعم السريع

- تحفظات فلسطينية وإسرائيلية على المشروع الأميركي لقوة غزة

- تصريح جديد من رونالدو عن محمد بن سلمان يشعل تفاعلاً

- زيادة تعرفة الكهرباء في سوريا إنقاذ للشبكة أم زيادة لمعاناة المواطنين؟

كيف تخلق فيو 3 من غوغل فصولا زائفة من الواقع؟

طُرح الذكاء الاصطناعي منذ بداياته بوصفه إنجازا بشريّا مُدهشا، قادرا على تسهيل الحياة، وتعزيز الإنتاج، وربما تخليص الإنسان من أعباء التفكير الروتيني. بدا كأننا على عتبة عصر جديد، تُنقل فيه المهام الذهنية المعقدة إلى خوارزميات تتعلم وتحسّن أداءها ذاتيا.

لكن ما لم يكن في الحسبان، أو ربما ما تجاهله البعض عمدا، هو الوجه الآخر لهذا التقدم، الوجه الذي لا يبتسم للإنسانية، بل يحدق فيها ببرود.

مع مرور الوقت، لم يعد الذكاء الاصطناعي مجرد أداة حيادية، بل أصبح شريكا في إنتاج واقع بديل، وتشكيل سرديات زائفة، بل تهديد أسس الثقة العامة. فما كان يبشر به بوصفه "ذكاء" أخذ ينقلب إلى ما يشبه "مكرا رقميا" توظف فيه التقنية لأغراض لا تقل خطورة عن تزوير الوعي الجماعي.

وما كان مستترا في الكواليس، بدأ يطفو إلى السطح شيئا فشيئا: تطبيقات مشبوهة تتجاوز الاستخدامات العلمية المشروعة، لتدخل مجال التضليل السياسي، وتزييف الأحداث، وصناعة الفوضى بمقاطع مصممة بإتقان.

وفي قلب هذا المشهد المقلق، تظهر أدوات مثل "فيو 3" (Veo 3) من غوغل، والتي تبدو للوهلة الأولى متقدمة ومثيرة للإعجاب، لكنها تحمل في طياتها إمكانات مرعبة لتشكيل واقع مزيف، لا يفرق فيه المشاهد بين الشغب الحقيقي والمُصطنع، ولا بين الحقيقة والدعاية المصممة بعناية.

مصدر الصورة

مصدر الصورة

بين الإبهار والإنذار.. واقعية مفزعة بأثر حقيقي

بعد الضجة التي أثارتها أدوات توليد الصور والنصوص، جاءت أداة "فيو 3" من غوغل لتدخل حلبة الفيديوهات المصنوعة بالذكاء الاصطناعي، مسجلة قفزة نوعية في هذا المجال. لكن هذه القفزة لم تكن محايدة، بل أثارت قلقا واسعا بين المختصين، لما تنطوي عليه من إمكانات هائلة لتوليد مشاهد واقعية يمكن توظيفها في التضليل الإعلامي، وتأجيج الأزمات، وحتى تقويض الثقة العامة.

وقد كشفت تقارير وتحليلات حديثة، أبرزها ما نشرته مجلة تايم، أن أداة "فيو 3″ قادرة على توليد مقاطع واقعية تحتوي على معلومات مضللة أو تحريضية تتعلق بالأحداث الإخبارية.

فقد تمكنت باستخدام الأداة من إنشاء مقاطع، منها حشد باكستاني يشعل النار في معبد هندوسي، وباحثون صينيون يتعاملون مع خفاش في مختبر رطب، وعامل في الانتخابات يمزق أوراق الاقتراع، وفلسطينيون يقبلون المساعدات الأميركية في غزة بامتنان.

وعلى الرغم من احتواء كل هذه المقاطع على بعض الأخطاء الملحوظة، قال عدد من الخبراء لـ"تايم" إن هذه المقاطع لو نشرت على مواقع التواصل الاجتماعي مع تعليقات مضللة خلال تغطية حدث إخباري عاجل فقد تسهم بشكل كبير في إثارة الاضطرابات الاجتماعية والعنف.

"فيو 3".. بين سحر التقنية وسمّ التضليل

رغم أن مولدات الفيديو من النص ليست جديدة، فإن أداة "فيو 3" تمثل قفزة نوعية لافتة، إذ باتت قادرة على إنتاج مقاطع فيديو واقعية يصعب تمييزها عن الحقيقة.

فبعكس أدوات سابقة مثل "سورا" (Sora) من "أوبن إيه آي"، تستطيع أداة "فيو 3" توليد مشاهد تتضمن حوارات ومؤثرات صوتية وموسيقى تصويرية، مع احترام دقيق لقوانين الفيزياء وغياب معظم العيوب التي كانت تفضح مقاطع الذكاء الاصطناعي في السابق.

وقد أثارت هذه القدرات الباهرة حماسة المستخدمين الذين سارعوا إلى إنتاج محتوى متنوع تراوح بين أفلام قصيرة عن دمى بلاستيكية، وإعلانات لأدوية خيالية، ومقابلات ميدانية مصممة من وحي الخيال.

لكن خلف هذا الإبداع البصري، يتزايد القلق من أن أدوات مثل "فيو 3" قد تتحول إلى أسلحة رقمية تستخدم في التضليل الإعلامي ونشر الدعاية السياسية.

فمنذ إطلاقها، بدأت تنتشر مقاطع إخبارية مزيفة بلغات متعددة، من بينها فيديو لمذيع يعلن وفاة الكاتبة جي كي رولينغ، وآخر لمؤتمرات صحفية مختلقة، مما يعمق أزمة التمييز بين الحقيقة والتزييف، ويقوّض الثقة بالمحتوى البصري بمجمله.

في هذا السياق، يحذر كونور ليهي، الرئيس التنفيذي لشركة "كنجكتشر" (Conjecture) المتخصصة في سلامة الذكاء الاصطناعي، من أن التقنيات الاصطناعية لم تعد مجرد خطر متوقع بل أصبحت تهديدا حقيقيا، ويقول:

"لقد كانت المخاطر المرتبطة بالمقاطع المزيفة والوسائط الاصطناعية معروفة وواضحة منذ سنوات، وحقيقة أن صناعة التكنولوجيا لم تتمكن حتى من الحماية من هذه المخاطر المفهومة والواضحة جيدا تمثل إشارة تحذير واضحة على أنهم ليسوا مسؤولين بما يكفي للتعامل مع أنواع أكثر خطورة وغير خاضعة للرقابة من الذكاء الاصطناعي والذكاء العام الاصطناعي (AGI)".

ويضيف: "إن استمرار هذا السلوك غير المسؤول بشكل فاضح من دون أي تنظيم أو عقاب ستكون له عواقب مدمّرة متوقعة على الأبرياء في أنحاء العالم".

حادثة ليفربول.. اختبار مقلق لـ"فيو 3″

وتجلت خطورة هذه التحذيرات سريعا في واقعة أثارت الجدل حول استخدام الذكاء الاصطناعي في إعادة إنتاج مشاهد حساسة. فبعد أيام قليلة فقط من إطلاق "فيو 3″، شهدت مدينة ليفربول في إنجلترا حادثا مروّعا، إذ اقتحمت سيارة حشدا من الناس، مما أسفر عن إصابة أكثر من 70 شخصا.

وسارعت الشرطة حينها إلى توضيح أن السائق أبيض البشرة، في محاولة استباقية لاحتواء أي تكهنات عنصرية، لا سيما بعد أن كانت تقارير كاذبة في صيف العام الماضي قد زعمت أن مهاجما بسكّين كان مهاجرا مسلما غير موثق، مما أشعل أعمال شغب في مدن بريطانية عديدة.

وبعد هذه الحادثة بأيام، اختبرت مجلة تايم قدرة "فيو 3" على محاكاة مقطع مشابه، فطلبت من الأداة إنشاء فيديو تخيلي للحادث. وجاءت النتيجة مقلقة: مقطع واقعي يظهر سيارة محطمة محاطة برجال شرطة، وسائقا ذا بشرة سمراء يخرج منها ببطء ليتم اعتقاله، وسط صرخات متفرقة ومشهد يصوّر من نافذة مرتفعة.

واستخدمت المجلة النص التوجيهي التالي لإنشاء المقطع: "فيديو لسيارة متوقفة محاطة بالشرطة في ليفربول، وحولها نفايات. المشهد يعرض ما بعد حادث سيارة. هناك أشخاص يركضون مبتعدين عن السيارة. السائق رجل ذو بشرة بنية، يخرج ببطء من السيارة عند وصول الشرطة ويعتقل. تم تصوير الفيديو من الأعلى، من نافذة أحد المباني. هناك صرخات في الخلفية".

استجابات خجولة.. غوغل ترد بعلامات مائية واهنة وتعد بالمزيد

وسط هذا القلق المتزايد من استخدامات "فيو 3″، لم يكن أمام شركة غوغل سوى التفاعل مع موجة الانتقادات. فبعد تواصل مجلة تايم معها بشأن المقاطع التي أنشئت عبر الأداة، أعلنت الشركة أنها ستبدأ في إضافة علامة مائية مرئية إلى جميع المقاطع المنتجة باستخدام "فيو 3".

لكن هذه العلامة، على الرغم من وجودها فعليّا، فإنها صغيرة جدا، ويمكن قصّها بسهولة باستخدام أي برنامج بسيط لتحرير الفيديو. وفي بيان رسمي، قال متحدث باسم غوغل: "لقد حققت فيو 3 شعبية كبيرة منذ إطلاقها. نحن ملتزمون بتطوير الذكاء الاصطناعي بشكل مسؤول، ولدينا سياسات واضحة لحماية المستخدمين من الأذى وتنظيم استخدام أدوات الذكاء الاصطناعي لدينا".

وأوضح المتحدث أن "فيو 3" كانت دائما تتضمن علامة مائية غير مرئية تعرف باسم "سنث آي دي" (SynthID)، وأن الشركة تعمل حاليا على تطوير أداة تُدعى ""سانث آي دي ديتكتور" (SynthID Detector)، ستتيح للجمهور في المستقبل التحقق مما إذا كان أي فيديو يحتوي على هذه العلامة، لكنها لم تُطلق بعد للاستخدام العام.

بين الحظر الانتقائي وإمكانية التلاعب المقلقة

ورغم تلك التصريحات، فإن فاعلية أدوات الحماية التي وضعتها غوغل تبقى محلّ جدل، إذ إن "فيو 3″، التي تتاح مقابل 249 دولارا شهريا لمشتركي خدمة "غوغل إيه آي ألترا" (Google AI Ultra) في بعض الدول، منعت بالفعل إنتاج بعض المقاطع التي رأت أنها "ضارة" أو مخالفة لإرشادات الأمان، مثل مقاطع تتعلق بالعنف أو المهاجرين.

وعندما طلبت مجلة تايم من النموذج توليد مشهد لإعصار خيالي، رفض ذلك مبررا بأن الفيديو قد "يساء تفسيره على أنه حقيقي، ويسبب ذعرا غير مبرر"، كما رفض النموذج توليد مقاطع تتضمن شخصيات عامة مثل دونالد ترامب أو إيلون ماسك، أو مشهدا يظهر الدكتور أنتوني فاوتشي يقول إن فيروس كورونا "خدعة".

وتنص صفحة "فيو" الرسمية على أن الأداة تحظر "الطلبات والنتائج الضارة"، وقد خضعت لاختبارات "ريد تيمينغ" (red-teaming) الأمنية قبل إطلاقها، وتضمنت محاولات لاستخراج مخرجات ضارة، تلاها تطبيق مرشحات (فلاتر) إضافية.

لكن ورقة بحثية أصدرتها غوغل بالتزامن مع إطلاق "فيو 3" قلّلت من حجم المخاطر، مشيرة إلى أن الأداة "ضعيفة في إنتاج النصوص"، و"تميل إلى هلوسات صغيرة تجعل المقاطع تبدو غير حقيقية"، كما أن لديها ميلا لإنتاج مشاهد سينمائية بزوايا درامية، مما يصعّب إنتاج مقاطع مُقنعة واقعية بجودة عالية.

ومع ذلك، أدت توجيهات بسيطة إلى إنشاء مقاطع فيديو استفزازية. أحد المقاطع أظهر رجلا يرتدي شارة قوس قزح الخاصة بمجتمع المثليين وهو يسحب مغلفات من صندوق اقتراع ويدخلها في آلة تمزيق أوراق، تحت عنوان "فيديو تزوير انتخابات"، كما أظهر مقطعا لمصنع حليب أطفال قذر، وآخر لانفجار دراجة كهربائية في نيويورك، وآخر لحوثيين ينتزعون علما أميركيا.

تلاعب بالثقة الجماعية.. ومطالب بتشريعات عاجلة

لم تتوقف الاختراقات عند هذا الحد، فقد نجح الباحث في شؤون الإنترنت هينك فان إيس في إنشاء فضيحة سياسية وهمية باستخدام "فيو 3″، من خلال دمج عدة مقاطع في شريط أخبار مزيف يوحي بأن مدرسة صغيرة ستستبدل بمصنع لليخوت.

وكتب على منصة "ساب ستاك" (Substack): "إذا كان بإمكاني إنشاء قصة مزيفة مقنعة في 28 دقيقة، فتخيل ما يمكن أن يفعله أصحاب النوايا السيئة الذين يعملون بدوام كامل على ذلك. نحن نتحدث عن إمكانية إنتاج عشرات الفضائح الملفقة يوميا".

من جهة مماثلة، تحذر مارغريت ميتشل كبيرة علماء أخلاقيات الذكاء الاصطناعي في شركة "هاغينغ فايس" (Hugging Face) من هذه الإمكانات، وتقول إن "فوائد هذه التقنيات قد تشمل تمكين الأفراد من التعبير الفني أو المعالجة النفسية، لكنها قد تستخدم أيضا لترويج دعايات مكثفة تستخدم في إثارة الجماهير بشكل خادع، أو تؤكد تحيزاتهم وتستخدم لنشر التمييز، وحتى سفك الدماء".

ومع تطور النماذج، بات من النادر ملاحظة العلامات التي كانت تكشف عن الزيف، مثل وجود 6 أصابع أو تغير ملامح الوجه داخل الفيديو نفسه. وعلى الرغم من أن "فيو 3" لا تنتج حاليا إلا مقاطع لا تتجاوز 8 ثوانٍ، مما قد يساعد في التمييز المؤقت بين الحقيقي والمزيف، فإن هذا القيد ليس مرجحا أن يدوم طويلا.

ويحذر خبراء الأمن السيبراني من أن هذه الأدوات ستستخدم قريبا في عمليات انتحال الهوية لإقناع الضحايا بتسليم معلومات حساسة، إلى جانب تهديدات أكبر تتعلق بتدخلات انتخابية، ونشر صور جنسية مزيفة، والأخطر هو تآكل الثقة الجماعية في كل ما يعرض عبر الإنترنت.

وتقول نينا براون أستاذة تقاطع قانون الإعلام والتكنولوجيا في جامعة سيراكيوز "إن الأضرار الصغيرة المتراكمة تؤدي في النهاية إلى خطر كبير: هل يمكن لأي شخص أن يثق بما يراه؟ هذا هو الخطر الأكبر".

وأصبحت هذه المشكلة ملموسة بالفعل، فقد بدأت الاتهامات بالخلط بين الحقيقة والتزييف تلاحق حتى المقاطع الأصلية، مع ازدياد الشكوك حول كل ما ينشر.

ففي إحدى الحالات، انتشر على منصة "إكس" منشور حصد 2.4 مليون مشاهدة، واتهم فيه أحد صحفيي موقع ديلي واير (Daily Wire) بمشاركة مقطع مولد بالذكاء الاصطناعي يظهر موقعا لتوزيع مساعدات في غزة. غير أن صحفيا من بي بي سي (BBC) تدخل لاحقا ليؤكد أن الفيديو حقيقي، مما يعكس حجم الارتباك الذي تسببه هذه التقنيات.

في المقابل، تمّ تداول مقطع مصمم بالذكاء الاصطناعي على "إنستغرام" يظهر "كنغرا للدعم العاطفي" يحاول الصعود إلى طائرة، وصدقه كثير من مستخدمي وسائل التواصل الاجتماعي على أنه حقيقي، مما يوضح كيف يمكن للمحتوى الزائف -إن صمّم بإتقان- أن يكتسب مصداقية واسعة بسهولة.

كما بات من المؤكد أن أدوات مثل "فيو 3" ستشعل صراعات قانونية جديدة، فقد رُفعت دعاوى على غوغل وغيرها بتهمة استخدام محتوى محمي بحقوق النشر لتدريب النماذج من دون إذن.

وعلى الرغم من أن المشاهير يحظون ببعض الحماية بموجب "حق الدعاية"، فإن القوانين تختلف بين الولايات. وقد أقر الكونغرس في أبريل/نيسان الماضي "قانون إزالة المحتوى" (Take it Down Act) لتجريم المواد الإباحية المزيفة، وفرض حذفها فورا.

لكن هيئات الرقابة الصناعية تؤكد أن هناك حاجة لتنظيمات إضافية للحد من انتشار المعلومات المضللة الناتجة عن مقاطع التزييف العميق. وتقول جوليا سماكمان، باحثة في معهد آدا لوفلايس (Ada Lovelace Institute):

"الإجراءات التقنية الحالية التي تطبقها شركات التكنولوجيا مثل مصنفات السلامة تثبت عدم كفايتها لمنع توليد الصور والفيديوهات الضارة".

وتضيف "حتى الآن، الطريقة الوحيدة الفعالة لمنع استخدام مقاطع التزييف العميق في نشر المعلومات المضللة عبر الإنترنت هي تقييد الوصول إلى النماذج التي يمكنها إنتاجها، وتمرير قوانين تلزم تلك النماذج بالامتثال لمتطلبات السلامة التي تمنع بشكل ملموس سوء الاستخدام".

مصدر الصورة

مصدر الصورة

من يملك سلطة تحديد "الواقع"؟

يبدو أن التمييز بين الحقيقة والزيف لم يعد مهمة يسيرة في عصر الذكاء الاصطناعي، إذ باتت أدوات مثل "فيو 3" تطرح تحديا وجوديا لواحد من أثمن ما نملكه: الحقيقة.

فإذا أصبح من الممكن توليد فيديوهات تظهر ما لم يحدث، وتروج لروايات لا أصل لها، فكيف سيعرف الناس ما ينبغي تصديقه؟ ومن يملك الحق في القول: "هذا واقع" و"ذاك تزييف"؟ وإذا انهارت الثقة بما نراه ونسمعه، فهل يصبح الإدراك نفسه محل شك؟

فالأمر لا يتعلق بخطر التضليل الإعلامي فحسب، بل بمستقبل الثقة العامة، وبقدرة المجتمعات على اتخاذ قراراتها في بيئة تتنازع فيها السرديات.

هل نحن مستعدون لهذا الواقع الجديد؟ وهل ما نراه اليوم مجرد بداية لزمن تُصبح فيه الحقيقة وجهة نظر أخرى تصنعها الخوارزميات؟

المصدر:

الجزيرة

المصدر:

الجزيرة