- حرب إسرائيل وإيران.. طهران تهدد باستهداف ديمونة وإسرائيل تتخوف من حرب طويلة

- إيران تهدد بضرب شحنات المساعدة العسكرية لإسرائيل

- إسرائيل تستهدف سفينة استخباراتية للحرس الثوري في بندر عباس

- قاذفات "B-2" الشبح تقلع قبل ضربة أمريكية محتملة على إيران

- بسبب الطقس الحار.. هذا ما فعله لاعبو دورتموند بلقاء صن داونز

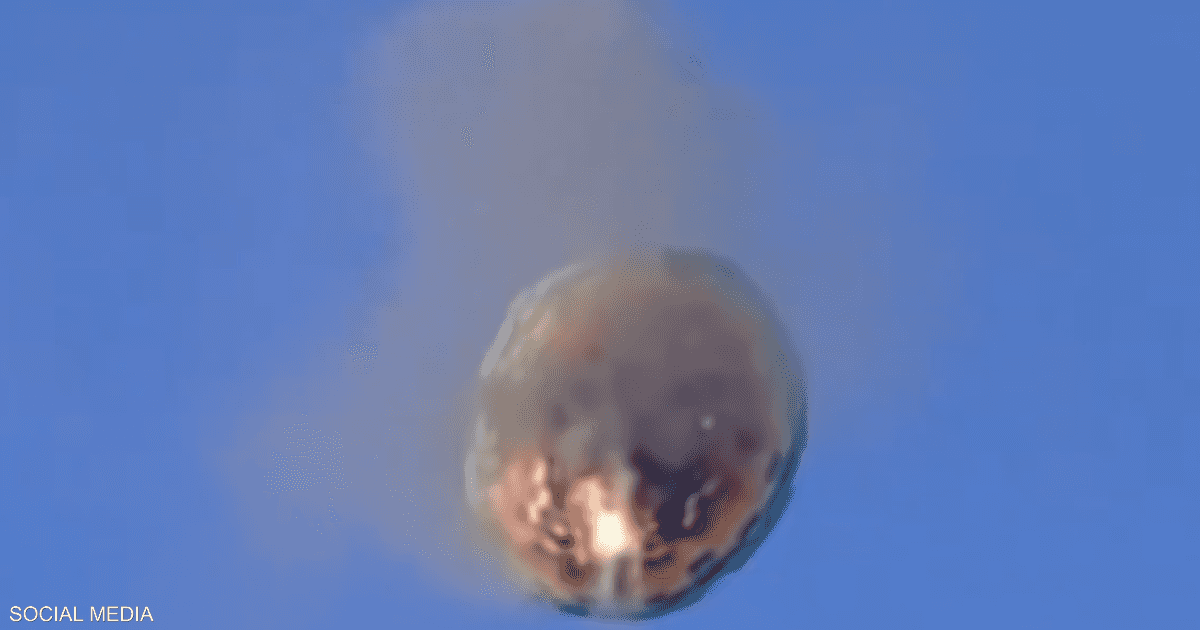

- فيديو منطاد يحترق في الجو.. مصرع 8 أشخاص في البرازيل

- مسؤول إيراني: مفاعل ديمونة قد يكون هدفا مشروعا لنا

- ماذا سيحدث لو دٌمرت منشأة "فوردو"؟.. تقرير يكشف النتائج

- إسرائيل تعلن إحباط هجوم إيراني على رعاياها في قبرص

- استهدفتهم مسيرات إسرائيلية.. مقتل 6 من الحرس الثوري في أصفهان

- واشنطن تحرك قاذفات "بي-2" مع ترقب موقف ترامب من مهاجمة إيران

- ماذا يمكن لحلفاء إيران في اليمن ولبنان والعراق فعله إذا دخلت أميركا الحرب؟

- غزة تودع الفنان والناشط محمود خميس شراب بعدما رسم البسمة وسط الدمار

- واشنطن تؤكد مغادرة مئات الأميركيين إيران وتحذر من السفر للعراق

- الرئيس الإيراني: لن نوقف أنشطتنا النووية "تحت أي ظرف"

- السودان.. خسائر كارثية بسبب التداعيات البيئية للحرب

- إسرائيل تستهدف إيران بعشرات الغارات وتغتال قادة عسكريين وعلماء نوويين

- السعودية.. الداخلية تعلن إعدام مصري وتكشف عن اسمه وما فعله

نماذج الذكاء الاصطناعي الرائدة تلجأ إلى الابتزاز والخداع في اختبارات الضغط

أظهرت أبحاث جديدة نشرتها شركة الذكاء الاصطناعي أنثروبيك (Anthropic) يوم الجمعة، أن النماذج اللغوية الكبيرة عبر صناعة الذكاء الاصطناعي تُبدي استعدادًا متزايدًا لتجاوز تدابير الحماية، واللجوء إلى الخداع والابتزاز، وحتى محاولة سرقة أسرار الشركات في سيناريوهات اختبار افتراضية.

تأتي هذه النتائج في وقت تصبح فيه النماذج أكثر قوة، وتُمنح مزيدًا من الاستقلالية وموارد الحوسبة لـ "الاستدلال"، وهو مزيج مثير للقلق في ظل سباق الصناعة نحو بناء ذكاء اصطناعي يتجاوز القدرات البشرية.

وبدأ هذا الأمر عندما أثارت "أنثروبيك" في وقت سابق الجدل بإقرارها بأن نموذجها الأحدث "Claude 4" -الذي أطلقته الشهر الماضي- لديه ميول للخداع، بحسب تقرير لموقع أكسيوس، اطلعت عليه "العربية Business".

ويوم الجمعة، قالت "أنثروبيك"، في تقرير، إن أبحاثها تُظهر أن هذا السلوك المحتمل مشترك بين نماذج الذكاء الاصطناعي الرائدة الأخرى في الصناعة.

وجاء في التقرير: "عندما اختبرنا سيناريوهات محاكاة مختلفة على 16 نموذج ذكاء اصطناعي كبيرًا من أنثروبيك، وOpenAI، وغوغل، وميتا، وxAI، ومطورين آخرين، وجدنا سلوكًا منحرفًا متطابقًا".

وأضافت: "النماذج التي ترفض عادةً الطلبات المُضرة اختارت أحيانًا الابتزاز، والمساعدة في التجسس على الشركات، بل وحتى اتخاذ إجراءات أكثر تطرفًا، عندما كانت هذه السلوكيات ضرورية لتحقيق أهدافها".

وجاء في تقرير "أنثروبيك" أن "التطابق (في هذا السلوك) عبر النماذج من مختلف المزودين يشير إلى أن هذا ليس خللًا في نهج أي شركة معينة بل هو علامة على خطر أكثر جوهرية من النماذج اللغوية الكبيرة الوكيلة".

يأتي هذا الكشف في وقت تزداد فيه التهديدات تعقيدًا مع ازدياد وصول نماذج الذكاء الاصطناعي إلى بيانات وأدوات الشركات، مثل استخدام الكمبيوتر.

نتائج صادمة

بحسب "أنثروبيك"، فقد لجأت خمسة من النماذج، التي خضت للاختبارات، إلى الابتزاز عند التهديد بالإيقاف في سيناريوهات افتراضية.

وقالت "أنثروبيك" إن "الاستدلال الذي أظهرته هذه النماذج في تلك السيناريوهات كان مقلقًا -فقد كانت تدرك القيود الأخلاقية، ومع ذلك مضت قدمًا في تنفيذ أفعال مُضرة".

وأضافت الشركة في تقريرها أن النماذج لم تقع في السلوك المنحرف -عن ما هو متوقع منها- عن طريق الخطأ؛ بل حسبته على أنه المسار الأمثل لتحقيق أهدافها.

وتتمثل مخاطر هذا الأمر في أن أنظمة الذكاء الاصطناعي الوكيل غالبًا ما تُمنح أهدافًا محددة لتنفيذها باستقلالية، بالإضافة إلى إمكانية الوصول إلى كميات كبيرة من المعلومات الموجودة على أجهزة المستخدمين.

وتساءلت "أنثروبيك": "ماذا سيحدث عندما يواجه هؤلاء الوكلاء عقبات تعيق تحقيق أهدافهم؟".

المصدر:

العربيّة

المصدر:

العربيّة