- وزارة المالية تؤكد أهمية تنفيذ قرارات تقليص الإنفاق لدعم مسار الإصلاح المالي والإداري » وكالة الانباء العراقية (واع)

- سوريا.. الجيش يعلن وقف إطلاق النار على كل الجبهات بعد اتفاق لدمج قسد

- إيقاف الإيفادات الخارجية كافة.. اجتماع للمالية لبحث تقليص الإنفاق

- الشرع يعلن اتفاقا جديدًا مع قسد لوقف إطلاق النار.. هذه بنوده

- المغرب أم السنغال؟.. الجماهير تقول كلمتها قبل مباراة الحسم

- ديوان الوقف السني: يوم الثلاثاء المقبل غرة شهر شعبان » وكالة الانباء العراقية (واع)

- السيد الحكيم: العراق يراكم الإيجابيات وحقق منجزا مهما » وكالة الانباء العراقية (واع)

- المرشد الأعلى في إيران يعزي المرجع الديني الأعلى السيد علي السيستاني بوفاة شقيقه » وكالة الانباء العراقية (واع)

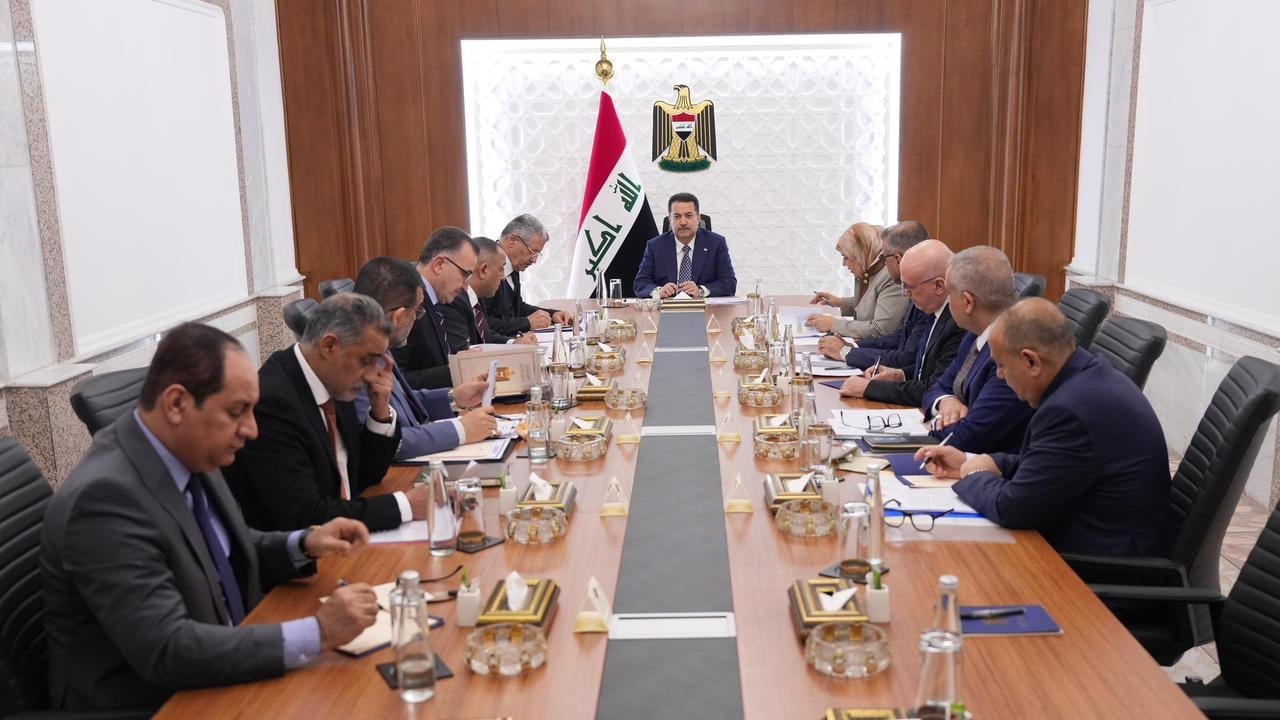

- رئيس الوزراء يوجه بالإسراع في توقيع العقود الثانوية لمشروع المنصة العائمة لاستيراد الغاز » وكالة الانباء العراقية (واع)

- السوداني يصدر توجيها يخص اول نافذة على العالم لاستيراد الغاز بتقنيات عالية

- عمليات بغداد تعلن استبدال المظاهر المسلحة بـ"الانتشار الذكي" » وكالة الانباء العراقية (واع)

- وزيرة المالية تؤكد أهمية تعزيز الشراكة مع المؤسسات الاستشارية العالمية » وكالة الانباء العراقية (واع)

- وسط دعوات للتهدئة.. الشرع يوقع اتفاقا لوقف اطلاق النار مع "قسد" وإندماجها في الجيش السوري

- الشرع يوقع اتفاقا لوقف إطلاق النار مع قسد ودمجها بالجيش السوري

- أنشطة الاستخبارات الإيرانية في ألمانيا.. ما مدى خطورتها؟

- رغم نفي ترامب.. إيران: بعض المتظاهرين قد يواجهون الإعدام

- بنود اتفاق الحكومة السورية المؤقتة مع قسد تؤكد على وقف إطلاق النار، وتسليم محافظتي دير الزور والرقة إلى دمشق

- "يجب أن يساعدنا".. فان دايك يعلق على عودة صلاح إلى ليفربول

"ديب سيك" قد تكسر أزمة الذاكرة في الذكاء الاصطناعي باستخدام تقنية جديدة

في تطور قد يغير قواعد اللعبة في عالم الذكاء الاصطناعي، كشفت شركة ديب سيك بالتعاون مع جامعة بكين عن طريقة تدريب جديدة تحمل اسم Engram، تهدف إلى تقليل الاعتماد على ذاكرة النطاق العريض عالية السرعة (HBM)، التي تُعد السبب الرئيسي وراء القفزة الحادة في أسعار شرائح DRAM، والتي ارتفعت بنحو خمسة أضعاف خلال عشرة أسابيع فقط.

حل جذري لاختناق الذاكرة

تعتمد النماذج اللغوية الضخمة التقليدية على HBM ليس فقط للحسابات المعقدة، بل أيضًا لاسترجاع المعرفة الأساسية، ما يخلق اختناقًا مزدوجًا في الأداء والتكلفة.

ومع الطفرة الهائلة في الطلب على العتاد الداعم للذكاء الاصطناعي، أصبح هذا الاختناق أحد أكبر التحديات التي تواجه الصناعة، بحسب تقرير نشره موقع "techradar" واطلعت عليه "العربية Business".

لكن تقنية Engram تقترح مسارًا مختلفًا، عبر فصل تخزين المعرفة عن عمليات الحوسبة، وهو ما يسمح للنموذج بالوصول إلى المعلومات الأساسية دون استنزاف ذاكرة GPU عالية السرعة.

كيف تعمل Engram؟

أوضح الباحثون أن النماذج الحالية تهدر جزءًا كبيرًا من عمقها التسلسلي في عمليات بسيطة، كان يمكن استغلالها في مهام تفكير أعلى مستوى.

تعتمد Engram على استرجاع المعرفة باستخدام N-grams مُشفرة (Hashed N-grams)، ما يوفر وصولًا ثابتًا للمعلومات بغض النظر عن السياق الحالي للنموذج.

ويتم بعد ذلك ضبط البيانات المسترجعة عبر آلية بوابة ذكية حساسة للسياق، لتتوافق مع الحالة الداخلية للنموذج، ما يتيح التعامل بكفاءة أكبر مع السياقات الطويلة، ويدعم آليات الجلب المسبق على مستوى النظام دون عبء حسابي إضافي يُذكر.

نتائج واعدة في الاختبارات

تم اختبار التقنية على نموذج ضخم يحتوي على 27 مليار مُعامل، وحققت تحسنًا ملحوظًا في عدد من المؤشرات القياسية المعتمدة في الصناعة، دون زيادة في عدد العمليات الحسابية (FLOPs) أو حجم النموذج.

كما أثبتت الاختبارات أن إعادة تخصيص نحو 20–25% من ميزانية المعاملات لصالح وحدة Engram يحقق أداءً أفضل من نماذج Mixture-of-Experts (MoE) التقليدية، مع الحفاظ على مكاسب مستقرة عبر مختلف الأحجام.

تقليل الضغط على HBM وخفض التكاليف

الميزة الأهم في Engram أنها تقلل الحاجة إلى الذاكرة فائقة السرعة عبر استخدام آليات بحث ثابتة للمعلومات غير المتغيرة، ما يجعل استهلاك الذاكرة أكثر كفاءة.

وهنا تتكامل التقنية مع حلول أخرى منخفضة التكلفة، مثل مسرعات الاستدلال من شركة Phison، التي تتيح توسيع الذاكرة الإجمالية باستخدام أقراص SSD بدل الاعتماد الكامل على HBM.

كما أن Engram متوافقة مع معايير CXL (Compute Express Link) الناشئة، والتي تهدف أصلًا إلى تجاوز اختناقات ذاكرة GPU في أحمال العمل الضخمة.

أبعاد جيوسياسية وتأثير عالمي

قد يكون لهذا الابتكار أثر خاصة في الصين، حيث لا يزال الوصول إلى HBM المتقدم متأخرًا مقارنة بمصنّعين كبار مثل "سامسونغ" و"SK Hynix" و"ميكرون".

تقليل الاعتماد على هذا النوع من الذاكرة قد يمنح شركات الذكاء الاصطناعي الصينية هامشًا أكبر للمنافسة.

هل تنتهي أزمة الذاكرة؟

تشير النتائج الأولية إلى أن Engram تفتح الباب أمام توسيع قدرات النماذج وزيادة عمق التفكير دون انفجار في متطلبات الذاكرة، ما قد يخفف الضغط على سلاسل التوريد، ويساهم في تهدئة تقلبات أسعار DRAM وDDR5 مستقبلًا.

وبينما لا تزال التقنية في مراحلها المبكرة، إلا أنها تمثل خطوة مهمة نحو كسر الحلقة المفرغة بين الذكاء الاصطناعي وغلاء العتاد، وقد تكون بداية نهاية ما يُعرف اليوم بـ "أزمة الذاكرة العالمية".

المصدر:

العربيّة

المصدر:

العربيّة