- الحرب على غزة.. خسائر للاحتلال ومعارك ضارية وحصيلة ثقيلة من الشهداء

- ما تأثير انسحاب أمريكا من مفاوضات وقف الحرب الروسية الأوكرانية؟

- روسيا: استعدنا 99% من أراضي كورسك التي سيطرت عليها أوكرانيا

- متى يحسم ريال مدريد مستقبل أنشيلوتي؟ المدرب الإيطالي يرد

- بوتين يعلن عن هدنة "عيد الفصح" في أوكرانيا

- جولة روما.. تفاصيل 4 ساعات من محادثات نووي إيران

- كوري ميلز: ناقشنا مع الشرع ملف العقوبات على سوريا

- الحوثي: أسقطنا مسيَرتين أميركيتين من طراز إم كيو 9 خلال 24 ساعة

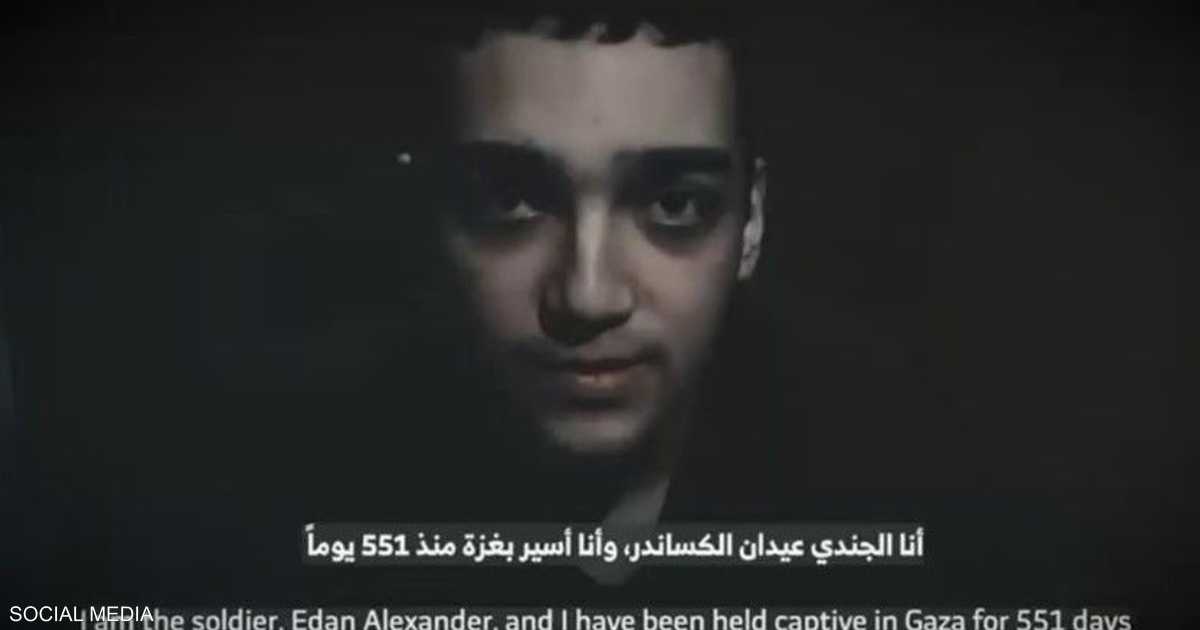

- القسام تبث تسجيلا مصورا لأسير إسرائيلي يتوسل للإفراج عنه

- روسيا تعلن هدنة مؤقتة بأوكرانيا وتقترب من استعادة كورسك بالكامل

- الأمان بالخرطوم يشجع الأهالي للعودة رغم الصعوبات

- انتهاء محادثات روما بين طهران وواشنطن وجولة جديدة خلال أيام

- مباشر مباراة برشلونة ضد سيلتا فيغو (1-2) في الدوري الإسباني

- يرافقه جدل سياسي وقانوني.. قصة المشروع العقاري الإسلامي بتكساس

- الأهلي يفرض التعادل السلبي على ماميلودي صن داونز

- لماذا تفضل إسرائيل الخيار العسكري في التعامل مع ملف إيران النووي؟

- عراقجي يعلق على مفاوضات روما.. ويعلن موعد الجولة القادمة

- نتيجة وملخص مباراة الأهلي ضد صن داونز في دوري أبطال أفريقيا

لعبة بوكيمون أصبحت إحدى معايير تفوق الذكاء الاصطناعي

حتى بوكيمون لم يسلم من جدل معايير الذكاء الاصطناعي.

في الأسبوع الماضي، انتشر منشور على منصة إكس على نطاق واسع، يزعم أن أحدث طراز من نموذج الذكاء الاصطناعي جيميني من "غوغل" تفوق على طراز "كلود" الرائد من "أنثروبيك" في ثلاثية لعبة بوكيمون الأصلية.

وأفادت التقارير أن جيميني وصل إلى "لافندر تاون" في بث مباشر لأحد المطورين على "تويتش"، بينما كان كلود عالقًا في "جبل مون" أواخر فبراير الماضي، بحسب تقرير نشره موقع "تك كرانش" واطلعت عليه "العربية Business".

كما أشار مستخدمو موقع ريديت، قام المطور المسؤول عن بث جيميني ببناء خريطة مصغرة مخصصة تساعد النموذج على تحديد القطع في اللعبة، مثل الأشجار القابلة للقطع. هذا يقلل من حاجة جيميني لتحليل لقطات الشاشة قبل اتخاذ قرارات اللعب.

الآن، يُعدّ بوكيمون معيارًا شبه جاد للذكاء الاصطناعي.

من ناحية أخرى أفادت شركة أنثروبيك بحصول نموذجها الحديث Anthropic 3.7 Sonnet على معيار SWE-bench Verified، المصمم لتقييم قدرات برمجة النموذج.

حقق Claude 3.7 Sonnet دقةً بنسبة 62.3% على معيار SWE-bench Verified، ولكن بنسبة 70.3% باستخدام أداة مخصصة طورتها "أنثروبيك".

مؤخرًا، قامت شركة ميتا بتحسين نسخة من أحد أحدث طرازاتها، Llama 4 Maverick، لتحقيق أداء جيد في معيار أداء محدد، LM Arena.

يُسجل الإصدار الأساسي من النموذج نتائج أسوأ بكثير في نفس التقييم.

ونظرًا لأن معايير أداء الذكاء الاصطناعي تُعتبر مقاييس غير مثالية في البداية، فإن التطبيقات المخصصة وغير القياسية تُهدد بزيادة الغموض.

بمعنى آخر، لا يبدو من المرجح أن تُصبح مقارنة النماذج أسهل مع إصدارها.

المصدر:

العربيّة

المصدر:

العربيّة