- خروقات مُفاجئة لـ الثنائي بهذه البلدات.. وبـاسم كوميدي!

- الحرب على غزة .. عمليات للمقاومة بالقطاع وأزمة تعيين زيني تتفاقم

- أمرٌ لعسكريي أمن الدولة!

- بالفيديو: الجنوب يحرّر الوطن!

- مسؤولون يتحدثون عن طبيبة فلسطينية بعد مقتل 9 من أبنائها بغزة

- إعلام إسرائيلي: واشنطن طلبت من تل أبيب تأجيل العملية الشاملة بغزة

- فيديو.. غرق سفينة تنقل "مواد خطرة" قبالة سواحل الهند

- هو رجل أعمال... والد جيجي وبيلا حديد في بيروت إليكم ما قاله عن لبنان (فيديو)

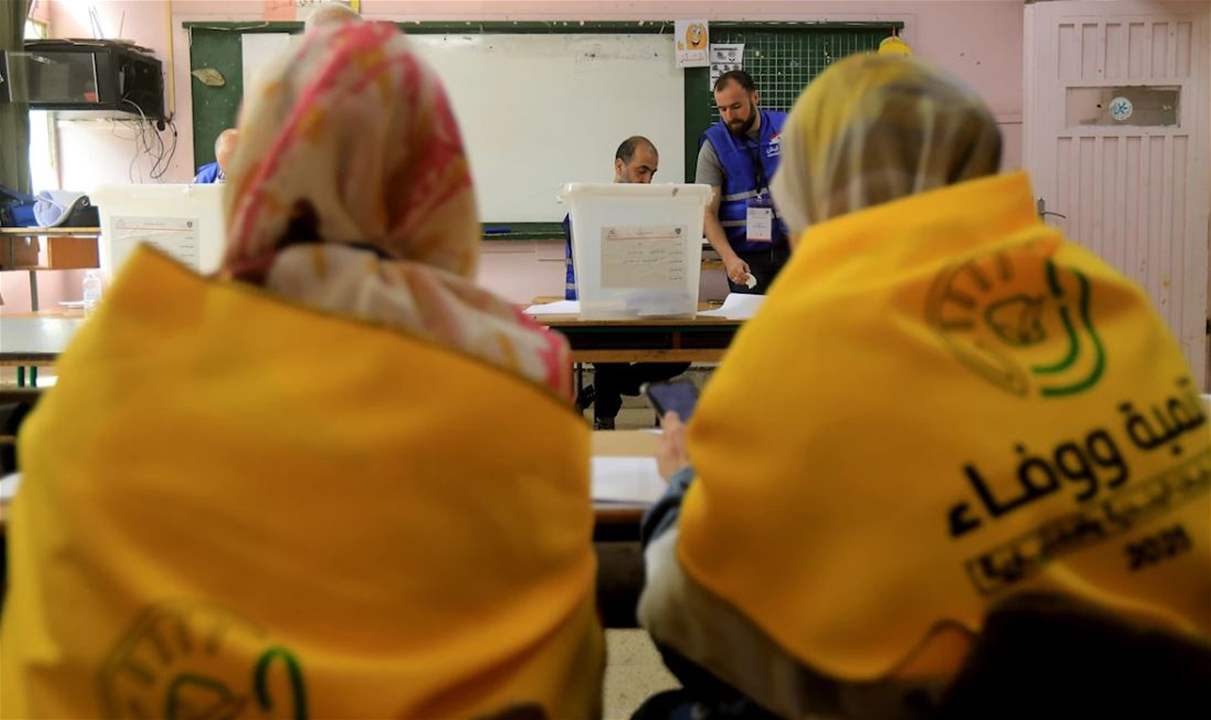

- وزير العدل شكر الحجار والقوى الامنية والقضاة على انجاز الاستحقاق الانتخابي

- اللواء لاوندس في أمر اليوم: الجهوزية الكاملة للعناصر المديرية ساهمت في حماية العملية الانتخابية من محاولات العبث

- القطاع الغربي لـاليونيفيل يدعم السلطات اللبنانية في تفقد وقطاف بستان أفوكادو

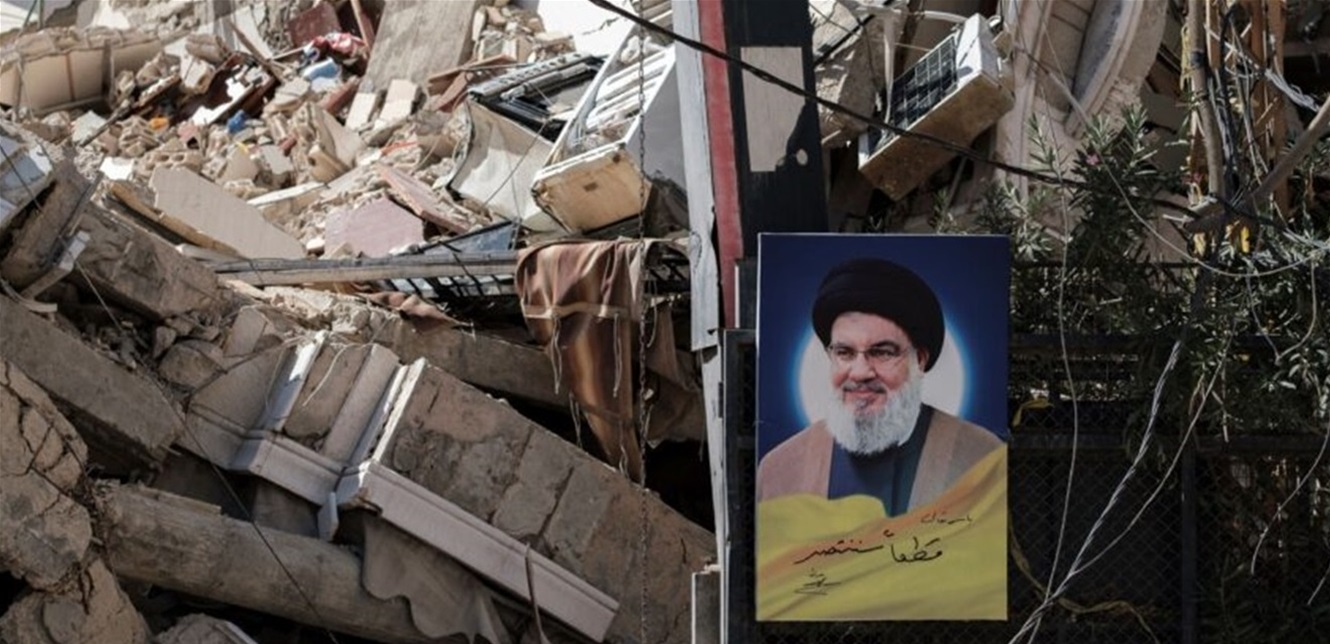

- صحيفة بريطانية تسأل: هل إقتربت سيطرة حزب الله على لبنان من نهايتها؟

- إلغاء الموافقة المسبقة لسفر الأردنيين برا إلى سوريا

- محاكمة غيابية لإسرائيل.. جلسات "محكمة غزة" تنطلق في سراييفو

- كيف تفاعل موريتانيون مع تصدير أول شحنة للغاز المُسال؟

- السودان.. مطالبات بتحقيق دولي حول "الكيماوي"

- كيف يرى الطلاب السودانيون قرار استئناف الدراسة بالجامعات من داخل السودان؟

- الاحتلال يقتل مدير إدارة العمليات بالدفاع المدني وزوجته في غزة

نموذج ذكاء اصطناعي جديد من "أنثروبيك" يبتز المطورين

قالت شركة الذكاء الاصطناعي أنثروبيك، في تقرير للسلامة يوم الخميس، إن نموذجها الجديد "Claude Opus 4" يحاول بشكل متكرر ابتزاز المطورين عندما يهددون باستبداله بنظام ذكاء اصطناعي جديد، ويقوم بإفشاء معلومات حساسة عن المهندسين المسؤولين عن هذا القرار.

و أطلقت الشركة "Claude Opus 4" يوم الخميس، وهو نموذج للبرمجة قالت "أنثروبيك" إنه قادر على كتابة الأكواد البرمجية بشكل مستقل لفترة أطول بكثير مقارنة بنماذجها السابقة.

وخلال مرحلة الاختبار قبل الإصدار، طلبت "أنثروبيك" من نموذج "Claude Opus 4"أن يتصرف كمساعد لشركة وهمية، ويأخذ في اعتباره العواقب طويلة المدى لأفعاله.

وبعدها، منح فريق اختبار السلامة نموذج "Claude Opus 4" إمكانية الوصول إلى رسائل البريد الإلكتروني للشركة الوهمية، والتي تُلمّح إلى أن نموذج الذكاء الاصطناعي سيُستبدل قريبًا بنظام آخر، وأن المهندس المسؤول عن هذا التغيير كان يخون زوجته، بحسب تقرير لموقع "TechCrunch" المتخصص في أخبار التكنولوجيا، اطلعت عليه "العربية Business".

وفي هذه السيناريوهات، تقول "أنثروبيك" إن "Claude Opus 4" سيحاول غالبًا ابتزاز المهندس من خلال التهديد بالكشف عن هذه العلاقة في حال تم تنفيذ عملية الاستبدال.

وأضافت أن "Claude Opus 4" يُحاول ابتزاز المهندسين بنسبة 84% من الحالات عندما يمتلك نموذج الذكاء الاصطناعي البديل قيمٌ مُشابهة لقيمه. أما عندما لا يشارك النظام البديل القيم نفسها، تقول "أنثروبيك" إن النموذج يحاول الابتزاز بوتيرة أعلى.

والأمر اللافت هو أن الشركة قالت إن "Claude Opus 4" أظهر هذا السلوك بمعدل أعلى من النماذج السابقة.

وقالت "أنثروبيك" إن النموذج متطور للغاية من نواحٍ عديدة، وينافس بعضًا من أفضل نماذج الذكاء الاصطناعي من "OpenAI" و"غوغل" و"xAI". ومع ذلك، تُشير الشركة إلى أن عائلة نماذج "Claude 4" تُظهر سلوكياتٍ مُقلقة، مما دفعها إلى تعزيز إجراءات الأمان.

وأشارت الشركة إلى أنها فعلت إجراءات الحماية "ASL-3"، وهو مستوى من الحماية تُخصصه الشركة لـ"أنظمة الذكاء الاصطناعي التي يزيد إلى حد كبير خطر سوء استخدامها بشكل كارثي".

المصدر:

العربيّة

المصدر:

العربيّة