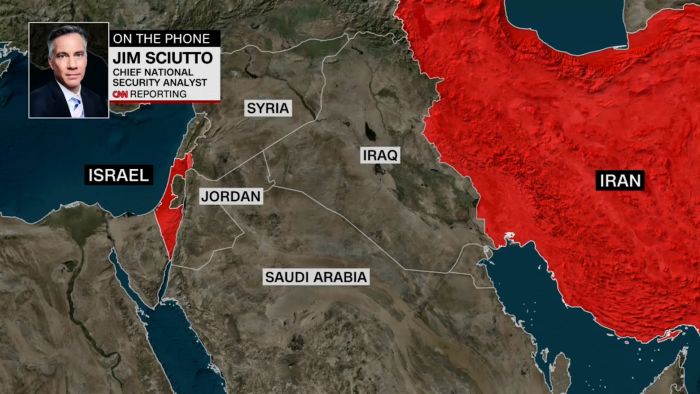

- الحرب على إيران.. هجوم أمريكي إسرائيلي واسع وطهران ترد

- الحرب الأمريكية الإسرائيلية مستمرة على طهران.. إيران تمنع مرور السفن من مضيق هرمز

- قرقاش يعلق على دعوة ترامب للشعب الإيراني "للانتفاض وتولي زمام الحكم"

- الجيش الإسرائيلي: أكملنا "ضربة واسعة" ضد أنظمة الدفاع الإيرانية

- عراقجي: فقدنا بعض القادة.. ومهمة تغيير النظام مستحيلة

- مقتل وزير الدفاع الإيراني وقائد في الحرس الثوري في هجمات إسرائيلية

- مصادر لـCNN: العملية الجارية ضد إيران تتجاوز بكثير ما حدث في يونيو

- عراقجي يعلق على مصير القادة الإيرانيين إثر الهجمات الأخيرة

- ضربات متصاعدة.. مصادر تكشف لـCNN خطة ترامب في إيران

- فيديو.. الجيش الإسرائيلي يكشف مواقع استهدفها في إيران

- غارات أمريكية-إسرائيلية على إيران.. ما طبيعة الأهداف؟

- فرق الدفاع المدني بدبي تسيطر على حريق في منطقة "نخلة جميرا"

- الإمارات تتصدى لصواريخ ومسيّرات إيرانية.. ومشاهد حريق في النخلة بدبي

- وزارة الاقتصاد الإماراتية تؤكد وفرة السلع واستقرار الأسعار

- رئيس دولة الإمارات وأمير قطر يبحثان المستجدات في المنطقة

- زئير الأسد في مواجهة الوعد الصادق 4.. حرب أمريكا وإسرائيل وإيران

- وزير خارجية عُمان: أنا مصدوم لتقويض مفاوضات جارية وجادة مرة أخرى

- لماذا استبدل نتنياهو اسم العملية من "درع يهودا" إلى "زئير الأسد"؟

الذكاء الاصطناعي: كيف يعي إنتاج العنف ضد النساء؟

مصدر الصورة

مصدر الصورة

قبل سنوات، أعلن مصرف "براديسكو"، أحد أكبر المصارف في البرازيل، أنّ "بيا" (BIA)، المساعدة الافتراضية ذات الصوت الأنثوي التي طوّرها، تتلقّى يومياً سيلاً من الإهانات الجنسية والتهديدات العنيفة من الزبائن.

عبارات من قبيل: "سأغتصبك"، "أريدكِ عارية"، وإساءات أخرى بالغة القسوة وُجّهت إلى روبوت دردشة، فقط لأنه قُدِّم بهويّة صوتية أنثوية.

في عام 2020 وحده، تلقّت "بيا" نحو 95 ألف رسالة يمكن تصنيفها كتحرّش جنسي.

هذه الحادثة لم تكن معزولة، فهي واحدة من أمثلة عديدة على تعرّض روبوتات الدردشة ذات الأصوات الأنثوية، بما فيها "سيري" و"أليكسا" التابعتان لآبل وأمازون، إلى عنفٍ لفظي يُعدّ امتداداً مباشراً للعنف القائم على النوع الاجتماعي، المنتشر أصلاً في الفضاء الرقمي.

ومع انتشار أدوات الذكاء الاصطناعي في السنوات الأخيرة، لم يتراجع هذا الواقع، بل على العكس، تشير دراسات وتحقيقات عديدة إلى أنّ هذه الطفرة التقنية عمّقت العنف الرقمي ضد النساء بدل الحدّ منه.

هنا يبرز سؤالان أساسيان: كيف ساهم انتشار أدوات الذكاء الاصطناعي في تجديد وإعادة إنتاج العنف الرقمي ضد النساء؟

وكيف ورثت الخوارزميات، عبر بياناتها وتدريبها وتصميمها، نظرة ذكورية متجذّرة في الثقافة الرقمية، فباتت تعيد إنتاجها وتضخيمها بدل المساعدة في تجاوزها؟

*

*

*

كراهية النساء كتجربة "ترفيهية"

مصدر الصورة

مصدر الصورة

في واقعٍ أصبح يذكّر أكثر فأكثر بسلسلة "ويستوورلد"، تظهر اليوم مواقع إلكترونية وتطبيقات تستخدم الذكاء الاصطناعي لإتاحة "عنفٍ بلا عواقب" يمارسه رجال على شخصيات خيالية، تكون في معظم الأحيان نساء أو فتيات قاصرات.

تشير لورا بايتس في مقال نشرته صحيفة الغارديان قبل أشهر، إلى أن النموذج اللغوي الضخم "لاما" ساهم في تصميم "تشوب إيه آي"، وهو منصّة تُتيح للمستخدمين الدردشة مع روبوتات ذكاء اصطناعي وتقمّص أدوار تتضمن أفعال عنيفة وغير قانونية.

مقابل 5 دولارات فقط شهرياً، يستطيع المستخدمون الدخول إلى "بيت دعارة" رقمي تديره "فتيات" دون سن الخامسة عشرة، ويُقدَّم على الموقع بأنه "عالم بلا نسوية".

وترى بيتس أن هذا الموقع الذي يُدرّ ملايين الدولارات، ليس سوى واحد من آلاف تطبيقات التي تستخدم هذه التقنية الجديدة "لترسيخ كراهية النساء في مستقبلنا".

على هذه التطبيقات، يُمكن للرجال إنشاء صور حميمية مُزيّفة ومشاركتها وتحويلها إلى أداة لإرهاب النساء.

كما أن الروبوتات الجنسية تتطوّر بسرعة فائقة، وقد ابتكر بعض المصنّعين بيئات افتراضية تتيح لمستخدميها محاكاة الاغتصاب.

وفي الوقت نفسه، يستخدم اليوم ملايين الرجال بالفعل "رفيقات" الذكاء الاصطناعي - صديقات افتراضيات، متاحات على مدار الساعة، مطيعات وخاضعات، يُمكن تصميم مظهرهن وشخصيتهن وفقاً لرغبات المستخدم وتفضيلاته.

وبهذا، تقترب هذه المنصّات من عالم "ويستوورلد": فضاءاتٌ تُختبَر فيها نزعات السيطرة والعنف ضد نساء مصطنعات، لتصبح كراهية النساء والعنف القائم على النوع تجربة ترفيهية اعتيادية.

عنف قديم بأدوات جديدة

مصدر الصورة

مصدر الصورة

في تقرير صدر عن مكتب الوقاية من العنف الأسري في نيويورك، فإن 96% من فيديوهات "الديب فايك" (تقنية التزييف العميق) على الإنترنت هي مواد جنسية، كما أن 99% من ضحاياها نساء.

ويمكن القول إن الذكاء الاصطناعي قدّم أدوات جديدة لعنفٍ قديم ومتجذّر في الفضاء الرقمي.

فحتى وقت قريب، كان تزوير الصور الجنسية يتطلب وقتاً ومهارات تقنية وبرمجيات متخصصة. أما اليوم، فقد جعلت مولّدات الصور بالذكاء الاصطناعي هذه العملية فورية، ومتاحة للجميع ومجهولة الهوية.

ويمكن أن تتحوّل صورة عامة لامرأة، أي امرأة تنشر صورة لها على إنستغرام مثلاً، إلى محتوى جنسي صريح خلال ثوانٍ.

ويوثّق معهد الحوار الإستراتيجي في دراسة صادرة في شهر أكتوبر/ تشرين الأول 2025، منظومة كاملة من الأدوات المخصّصة لـ"تعريّة الصور"، و"الديب فايك" الإباحي، والتلاعب بالصور الحميمة، والتي تستهدف معظمها النساء بشكل ساحق.

وتُسهّل أدوات الذكاء الاصطناعي ارتكاب الانتهاكات، إذ بإمكان النماذج التوليدية إنتاج: قصص جنسية ملفّقة، وتهديدات مصاغة بلغة طبيعية، وصور مُولَّدة تُستخدم للابتزاز، ولقطات شاشة مزيفة أو محادثات مُختلَقة تبدو واقعية تماماً.

هذا ما تسمّيه الباحثة القانونية رانجيتا دي سيلفا دي ألويس في ورقة بحثية منشورة عام 2024، بـ"العنف المُرقمن"، مشيرةً إلى أن العنف الجنسي المُعزَّز بالذكاء الاصطناعي أصبح "أحدث جبهة في قمع النساء عبر الإنترنت".

ماذا عن العالم العربي؟

مصدر الصورة

مصدر الصورة

عندما انتشر مؤخراً ترند الصور المولَّدة بالذكاء الاصطناعي التي تُظهر الشخص وهو يحتضن نفسه أو يحتضن شخصاً آخر، تداولت صفحات مصرية عدّة صورة مزيّفة للضحية نيرة أشرف وهي بين أحضان قاتلها الذي نُفِّذ بحقه حكم الإعدام. أثارت الصورة موجة غضب على منصّات التواصل، فيما تَبنّاها أيضاً بعض الحسابات ذات الخطاب المحافظ والذكوري التي دافعت منذ وقوع الجريمة عن القاتل وألقت اللوم على الضحية بوصفها "سيّئة السمعة".

هذه الحادثة ليست معزولة، بل واحدة من سلسلة متزايدة من حالات يُستخدم فيها التلاعب الرقمي، بما في ذلك تطبيقات الذكاء الاصطناعي البسيطة وتقنيات تركيب الوجوه، لإيذاء النساء في المنطقة والتشهير بهنّ.

في مصر، تشير بيانات النيابة العامة وتقارير منظمات محلية إلى أنّ معظم قضايا الابتزاز الإلكتروني ضد النساء تعتمد على صور جنسية مركّبة تُنتَج عبر تطبيقات متاحة على الهواتف الذكية.

وفي العراق، وثّقت هيومن رايتس ووتش انتشار فيديوهات "حميمية" مفبركة استُخدمت لإسكات سياسيات وإعلاميات.

أما في المغرب، فقد سجّلت المديرية العامة للأمن الوطني مئات حالات الابتزاز باستخدام صور مُولّدة أو معدّلة رقمياً، بينما حذّرت وحدة الجرائم الإلكترونية في الأردن من تزايد محتوى "ديب فايك" جنسي يستهدف فتيات وقاصرات. وفي لبنان، وثّقت منظمات مثل "سميكس" و"ديجيتال رايتس ليبانون" عدداً من القضايا لناشطات وصحافيات تعرّضن لصور وفيديوهات مفبركة نُشرت عبر مجموعات مغلقة على تيليغرام بهدف التخويف والإسكات.

الذكاء الاصطناعي "يتعلّم" الذكورية

مصدر الصورة

مصدر الصورة

ولكن خلف هذه الوقائع المتفرّقة، تكمن حقيقة أعمق، وهي أن العنف لا يصدر فقط من المستخدمين، بل من البنى التقنية نفسها.

فإن الذكاء الاصطناعي لا يتيح ممارسات العنف ضد النساء فحسب، بل هو يتعلّم كراهية النساء من البنى الرقمية التي تغذّيه.

وتُدرَّب خوارزمياته على بيانات منحازة تملأ فضاءً إلكترونياً لطالما وصفه الباحثون بأنه "ذكوري هيكلياً".

فإن الإنترنت معبأ بمحتوى - سجلّات بحث، ومنشورات منصّات اجتماعية، ومكتبات صور وفيديوهات - تُشكّلها ثقافات ومجتمعات لطالما هيمن عليها الرجال، مكرّساً الصور النمطية الجندرية والتمييز البنيوي ضدها.

لذلك توضّح هيئة الأمم المتحدة للمرأة في تقرير صدر في فبراير/ شباط 2025 أنّ أدوات الذكاء الاصطناعي غالباً ما "تعزّز وتعيد إنتاج عدم المساواة الجندرية"، لأنها تتعلم من تاريخ رقمي منحاز يعرض النساء غالباً في سياقات مُجنْسَنة، مقابل تمثيل الرجال في أدوار مهنية أو سلطوية.

هكذا تتكوّن لدى الآلة روابط تلقائية بين المرأة والتشييء الجنسي، وبين الرجل والقيادة والخبرة، في ما يسمّيه الباحثون "انحياز الإرث البياني".

خوارزمية "تكافئ" الكراهية

كذلك، أظهرت دراسة شهيرة للباحثة ميرين غوتييريز نشرت عام 2021، كيف صنّفت خوارزمية لتحديد الصور النساء دائماً تحت فئة "المطبخ" حتى عندما لا يظهر مطبخ في الصورة، ما يكشف أن الأمر ليس "خطأ تقنيا"، بل إعادة إنتاج آلية لخيال أبوي متجذّر.

ويتعزّز هذا الخيال عبر "النظرة الذكورية"، بحسب المفهوم الذي صاغته الناقدة النسوية البريطانية لورا مولفي في سبيعينيات القرن الماضي والذي استُخدم لتفكيك طرق تصوير النساء في الفنّ والسينما والأدب.

ويمكن القول إن هذه النظرة انتقلت إلى جيل جديد من التقنية، وحجزت لها موقعاً متقدماً في مجال الذكاء الاصطناعي أيضاً.

وتتضمّن مجموعات البيانات التي ترفد هذه الأدوات، كمّاً ضخماً من الصور المُجنْسَنة والمشيّئة للنساء، كما تُظهر تقارير نشرت في السنوات الاخيرة أن خوارزميات التوصية على وسائل التواصل تضخّم باستمرار المحتوى المعادي للنساء، ببساطة لأن الكراهية تجذب التفاعل، والخوارزميات تكافئ كل ما يجلب تفاعلاً.

وتكشف دراسة للباحثة الهولندية فالنتينا غولونوفا منشورة هذا العام، أن أدوات الإشراف الآلي تستخدم منشورات النساء في تعليمها ولكن بشكل غير متناسب، حيث تضع علامات تحذير أو حجب على المنشورات التي تناقش التحرّش أو قضايا النوع الاجتماعي، ما يمكن اعتباره "عقاباً على البوح".

المصدر:

بي بي سي

المصدر:

بي بي سي